AI – TrГӯ Tuб»Ү NhГўn TбәЎo CГі PhбәЈi Дҗang LГ Mб»‘i Дҗe Dб»Қa?

TrГӯ thГҙng minh nhГўn tбәЎo (AI) Д‘ang mб»ҹ ra nhб»Ҝng cГЎnh cб»ӯa mб»ӣi trong thб»қi Д‘бәЎi hiб»Үn Д‘бәЎi. Tuy nhiГӘn, nбәҝu khГҙng ГЎp dб»Ҙng Д‘Гәng cГЎch vГ kiб»ғm soГЎt chбә·t chбәҪ, AI cГі thб»ғ trб»ҹ thГ nh mб»‘i Д‘e dб»Қa Д‘ГЎng kб»ғ Д‘б»‘i vб»ӣi loГ i ngЖ°б»қi.

KhГҙng thб»ғ phủ nhбәӯn rбәұng trГӯ thГҙng minh nhГўn tбәЎo (AI) mang Д‘бәҝn nhiб»Ғu Ж°u Д‘iб»ғm, tuy nhiГӘn, khi cГҙng nghб»Ү nГ y vЖ°б»Јt quГЎ khбәЈ nДғng kiб»ғm soГЎt của con ngЖ°б»қi, nguy cЖЎ tiб»Ғm бә©n cЕ©ng gia tДғng Д‘ГЎng kб»ғ. Vбәӯy trong tЖ°ЖЎng lai AI cГі phбәЈi lГ mб»‘i Д‘e dб»Қa của con ngЖ°б»қi hay khГҙng thГ¬ cГ№ng NativeX tГ¬m hiб»ғu trong bГ i viбәҝt nГ y nhГ©.

TrГӯ thГҙng minh nhГўn tбәЎo cГі thбәӯt sб»ұ бәЈnh hЖ°б»ҹng Д‘бәҝn con ngЖ°б»қi

Nhб»Ҝng nguy cЖЎ của trГӯ thГҙng minh nhГўn tбәЎo Д‘б»‘i vб»ӣi con ngЖ°б»қi

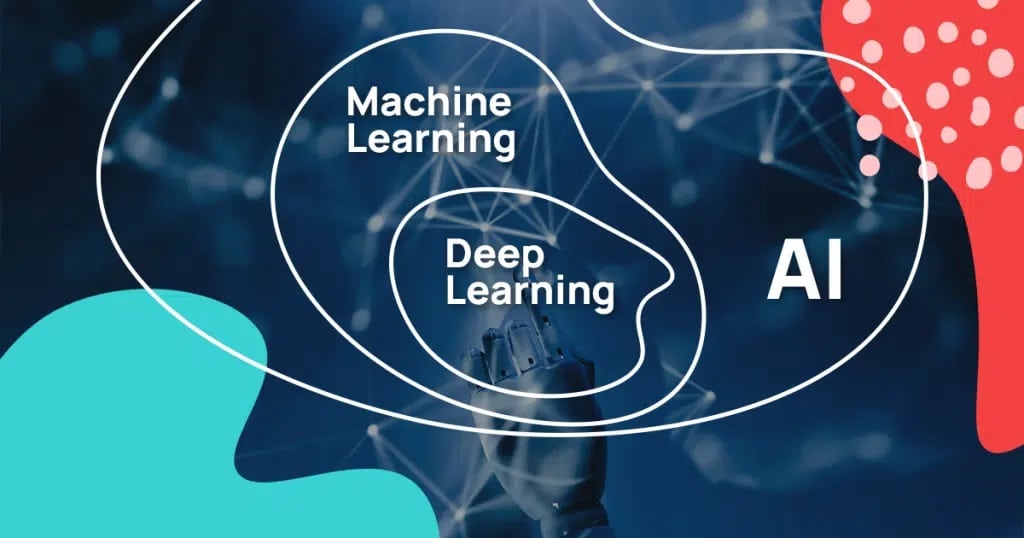

TrГӯ tuб»Ү nhГўn tбәЎo (AI) lГ mб»ҷt lД©nh vб»ұc trong khoa hб»Қc mГЎy tГӯnh, liГӘn quan Д‘бәҝn viб»Үc mГҙ phб»Ҹng quГЎ trГ¬nh ra quyбәҝt Д‘б»Ӣnh vГ tЖ° duy giб»‘ng nhЖ° con ngЖ°б»қi. CГЎc chЖ°ЖЎng trГ¬nh nГ y cГі khбәЈ nДғng tб»ұ Д‘б»ҷng Д‘iб»Ғu chб»үnh cГЎc thuбәӯt toГЎn bбәұng cГЎch phГўn tГӯch dб»Ҝ liб»Үu vГ cбәЈi thiб»Үn hiб»Үu suбәҘt mГ khГҙng cбә§n sб»ұ can thiб»Үp của con ngЖ°б»қi.

CГўu trбәЈ lб»қi vб»Ғ nhб»Ҝng rủi ro бә©n sau trГӯ thГҙng minh nhГўn tбәЎo (AI) vбә«n chЖ°a rГө rГ ng, khi cГЎc chuyГӘn gia hГ ng Д‘бә§u tiбәҝp tб»Ҙc tranh luбәӯn vб»Ғ mб»©c Д‘б»ҷ nguy hiб»ғm của cГҙng nghб»Ү nГ y. Tuy nhiГӘn, hб»Қ Д‘ГЈ Д‘б»“ng thuбәӯn vб»Ғ nhб»Ҝng lo ngбәЎi hiб»Үn nay, nбәҝu khГҙng cГі biб»Үn phГЎp phГІng trГЎnh thГӯch hб»Јp.

Khi trГӯ tuб»Ү nhГўn tбәЎo (AI) xuбәҘt hiб»Үn, nhiб»Ғu hoбәЎt Д‘б»ҷng trong cuб»ҷc sб»‘ng hГ ng ngГ y trб»ҹ nГӘn thuбәӯn tiб»Үn hЖЎn. Tuy nhiГӘn, cГҙng nghб»Ү nГ y vбә«n Д‘Ж°a ra nhб»Ҝng thГЎch thб»©c Д‘ГЎng kб»ғ, Д‘бә·c biб»Үt lГ trong viб»Үc tЖ°ЖЎng tГЎc vб»ӣi con ngЖ°б»қi.

TrГӯ tuб»Ү nhГўn tбәЎo (AI) cГі khбәЈ nДғng hoбәЎt Д‘б»ҷng Д‘б»ҷc lбәӯp dб»ұa trГӘn lбәӯp trГ¬nh của con ngЖ°б»қi

Nбәҝu Д‘Ж°б»Јc sб»ӯ dб»Ҙng vб»ӣi mб»Ҙc Д‘Гӯch khГҙng Д‘Гәng, cГҙng nghб»Ү nГ y cГі thб»ғ tбәЎo ra nhб»Ҝng hбәӯu quбәЈ khГі lЖ°б»қng, nhЖ° thao tГәng quan Д‘iб»ғm xГЈ hб»ҷi hoбә·c phб»• biбәҝn thГҙng tin khГҙng chГӯnh xГЎcвҖҰ

Mб»ҷt trong nhб»Ҝng Ж°u Д‘iб»ғm lб»ӣn của AI lГ khбәЈ nДғng tб»ұ Д‘б»ҷng hГіa cГҙng viб»Үc, tб»« Д‘Гі giбәЈm bб»ӣt gГЎnh nбә·ng lao Д‘б»ҷng cho con ngЖ°б»қi. Trong nhiб»Ғu ngГ nh cГҙng nghiб»Үp, quГЎ trГ¬nh sбәЈn xuбәҘt vГ dб»Ӣch vб»Ҙ cГі thб»ғ Д‘Ж°б»Јc tб»‘i Ж°u hГіa, giГәp tiбәҝt kiб»Үm thб»қi gian vГ chi phГӯ. Tuy nhiГӘn, con ngЖ°б»қi cГі thб»ғ sбәҪ mбәҘt cГҙng viб»Үc nбәҝu chГәng ta chб»ү tбәӯn dб»Ҙng cГЎc loбәЎi mГЎy mГіc hiб»Үn Д‘бәЎi.

AI cГі thб»ғ tб»ұ Д‘б»ҷng hoГЎ cГЎ loбәЎi mГЎy mГіc trong ngГ nh sбәЈn xuбәҘt vГ cГҙng nghiб»Үp

NativeX – Hб»Қc tiбәҝng Anh online toГ n diб»Үn “4 kб»№ nДғng ngГҙn ngб»Ҝ” cho ngЖ°б»қi Д‘i lГ m.

Vб»ӣi mГҙ hГ¬nh “Lб»ӣp Hб»Қc NГ©n” Д‘б»ҷc quyб»Ғn:

- TДғng hЖЎn 20 lбә§n chбәЎm “Д‘iб»ғm kiбәҝn thб»©c”, giГәp hiб»ғu sГўu vГ nhб»ӣ lГўu hЖЎn gбәҘp 5 lбә§n.

- TДғng khбәЈ nДғng tiбәҝp thu vГ tбәӯp trung qua cГЎc bГ i hб»Қc cГҙ Д‘б»Қng 3 – 5 phГәt.

- RГәt ngбәҜn gбә§n 400 giб»қ hб»Қc lГҪ thuyбәҝt, tДғng hЖЎn 200 giб»қ thб»ұc hГ nh.

- HЖЎn 10.000 hoбәЎt Д‘б»ҷng cбәЈi thiб»Үn 4 kб»№ nДғng ngoбәЎi ngб»Ҝ theo giГЎo trГ¬nh chuбә©n Quб»‘c tбәҝ tб»« National Geographic Learning vГ Macmillan Education.

BбәЈn ghi Podcast

Mб»ҷt sб»‘ tб»« ngб»Ҝ trong bбәЈn ghi tб»« chЖ°ЖЎng trГ¬nh DataFramed sбәҪ Д‘Ж°б»Јc NativeX Д‘iб»Ғu chб»үnh lбәЎi sao cho phГ№ hб»Јp vГ dб»… hiб»ғu dГ nh cho bбәЎn Д‘б»Қc.

Adel Nehme: Xin chГ o mб»Қi ngЖ°б»қi, chГ o mб»«ng Д‘бәҝn vб»ӣi DataFramed. MГ¬nh lГ Adel, NhГ TuyГӘn truyб»Ғn vГ GiГЎo viГӘn vб»Ғ Dб»Ҝ liб»Үu tбәЎi Datacamp. Nбәҝu bбәЎn lГ ngЖ°б»қi mб»ӣi, thГ¬ DataFramed lГ mб»ҷt podcast hГ ng tuбә§n, nЖЎi chГәng tГҙi khГЎm phГЎ cГЎch cГЎ nhГўn vГ tб»• chб»©c cГі thб»ғ thГ nh cГҙng vб»ӣi dб»Ҝ liб»Үu vГ trГӯ tuб»Ү nhГўn tбәЎo. ДҗГЈ gбә§n mб»ҷt nДғm kб»ғ tб»« khi ChatGPT Д‘Ж°б»Јc ra mбәҜt, Д‘Ж°a trГӯ tuб»Ү nhГўn tбәЎo vГ o ГҪ thб»©c chung vГ quГЎ trГ¬nh nГ y.

Tб»« khoбәЈnh khбәҜc Д‘Гі, chГәng ta Д‘ГЈ chб»©ng kiбәҝn mб»ҷt cuб»ҷc tranh luбәӯn sГҙi nб»•i trong cб»ҷng Д‘б»“ng dб»Ҝ liб»Үu vГ trГӯ tuб»Ү nhГўn tбәЎo, cЕ©ng nhЖ° trong cuб»ҷc Д‘б»‘i thoбәЎi cГҙng cб»ҷng nГіi chung. Trб»Қng tГўm của cuб»ҷc tranh luбәӯn nГ y lГ liб»Үu trГӯ tuб»Ү nhГўn tбәЎo cГі hoбә·c sбәҪ dбә«n Д‘бәҝn rủi ro tб»“n tбәЎi cho loГ i ngЖ°б»қi hay khГҙng. ChГәng ta Д‘ГЈ thбәҘy nhб»Ҝng tГЎc giбәЈ nhЖ°: Eliezer Yudkowsky, Yuval Noah Harari vГ nhб»Ҝng ngЖ°б»қi khГЎc kГӘu gб»Қi bГЎo Д‘б»ҷng vб»Ғ viб»Үc AI cГі thб»ғ nguy hiб»ғm khГҙng kГ©m, thбәӯm chГӯ cГІn nguy hiб»ғm hЖЎn cбәЈ vЕ© khГӯ hбәЎt nhГўn.

ChГәng ta cЕ©ng Д‘ГЈ thбәҘy cГЎc nhГ nghiГӘn cб»©u vб»Ғ trГӯ tuб»Ү nhГўn tбәЎo vГ nhб»Ҝng nhГ lГЈnh Д‘бәЎo doanh nghiб»Үp kГҪ tГӘn cГЎc Д‘ЖЎn kiбәҝn nghб»Ӣ vГ Д‘бә©y mбәЎnh Д‘б»ғ chГӯnh phủ Д‘Ж°a ra quy Д‘б»Ӣnh nghiГӘm ngбә·t vб»Ғ trГӯ tuб»Ү nhГўn tбәЎo. NgЖ°б»Јc lбәЎi, chГәng ta cЕ©ng Д‘ГЈ thбәҘy nhб»Ҝng ngЖ°б»қi nб»•i tiбәҝng trong lД©nh vб»ұc nГ y, nhЖ°: Andrew Ng vГ Yann LeCun, kГӘu gб»Қi sб»ұ phГЎt triб»ғn của mГЈ nguб»“n mб»ҹ vб»Ғ trГӯ tuб»Ү nhГўn tбәЎo, khГҙng phбәЈi chб»‘ng lбәЎi. Vбәӯy lГ m thбәҝ nГ o chГәng ta cГі thб»ғ Д‘iб»Ғu hЖ°б»ӣng trong cuб»ҷc tranh luбәӯn nГ y?

VГ thб»ұc sб»ұ, mб»©c Д‘б»ҷ rủi ro của trГӯ tuб»Ү nhГўn tбәЎo nбәұm б»ҹ Д‘Гўu? Quan trб»Қng hЖЎn, lГ m thбәҝ nГ o chГәng ta cГі thб»ғ Д‘бә·t nguy cЖЎ của trГӯ tuб»Ү nhГўn tбәЎo vГ o bб»‘i cбәЈnh vб»ӣi cГЎc nguy cЖЎ hб»Ү thб»‘ng khГЎc mГ nhГўn loбәЎi Д‘ang Д‘б»‘i mбә·t, nhЖ° biбәҝn Д‘б»•i khГӯ hбәӯu, rủi ro của chiбәҝn tranh hбәЎt nhГўn, vГ nhб»Ҝng vбәҘn Д‘б»Ғ khГЎc nб»Ҝa?В

LГ m thбәҝ nГ o chГәng ta cГі thб»ғ quy Д‘б»Ӣnh trГӯ tuб»Ү nhГўn tбәЎo mГ khГҙng rЖЎi vГ o bбә«y của sб»ұ kiб»ғm soГЎt quy Д‘б»Ӣnh, nЖЎi mб»ҷt vГ i ngЖ°б»қi Ж°u tГә vГ mбәЎnh mбәҪ hЖ°б»ҹng lб»Јi tб»« quy Д‘б»Ӣnh, lГ m chГ¬m Д‘uб»‘i Д‘б»‘i thủ trong quГЎ trГ¬nh nГ y?

Дҗб»ғ giбәЈi Д‘ГЎp nhб»Ҝng cГўu hб»Ҹi nГ y, chГәng ta sбәҪ trГІ chuyб»Үn vб»ӣi Гҙng Trond Arne Undheim. Trond Arne Undheim lГ mб»ҷt nghiГӘn cб»©u viГӘn vб»Ғ rủi ro hб»Ү thб»‘ng toГ n cбә§u, Д‘б»•i mб»ӣi vГ chГӯnh sГЎch tбәЎi ДҗбәЎi hб»Қc Stanford, Гҙng lГ ngЖ°б»қi Д‘б»©ng Д‘бә§u Cascading Risks Study, mб»ҷt nghiГӘn cб»©u nhбәұm hiб»ғu rГө cГЎch cГЎc rủi ro hб»Ү thб»‘ng khГЎc nhau mГ chГәng ta Д‘б»‘i mбә·t vГ tЖ°ЖЎng tГЎc vб»ӣi nhau.

Г”ng cЕ©ng lГ Д‘б»‘i tГЎc Д‘бә§u tЖ° tбәЎi Antler, mб»ҷt cГҙng ty quб»№ Д‘бә§u tЖ° mбәЎo hiб»ғm giai Д‘oбәЎn Д‘бә§u toГ n cбә§u Д‘бә§u tЖ° vГ o cГЎc cГҙng ty cГҙng nghб»Ү. Г”ng lГ CEO vГ Д‘б»“ng sГЎng lбәӯp Yegii, mб»ҷt mбәЎng lЖ°б»ӣi hiб»ғu biбәҝt vб»ӣi cГЎc chuyГӘn gia vГ tГ i sбәЈn tri thб»©c vб»Ғ sб»ұ Д‘бәЈo lб»ҷn. Г”ng cЕ©ng lГ mб»ҷt nghiГӘn cб»©u viГӘn khГҙng cЖ° trГә tбәЎi Hб»ҷi Д‘б»“ng ДҗбәЎi TГўy DЖ°ЖЎng, vб»ӣi mб»ҷt danh mб»Ҙc Д‘a dбәЎng vб»Ғ trГӯ tuб»Ү nhГўn tбәЎo, tЖ°ЖЎng lai của cГҙng viб»Үc, Д‘бәЎo Д‘б»©c dб»Ҝ liб»Үu, cГЎc cГҙng nghб»Ү mб»ӣi nб»•i, khб»ҹi nghiб»Үp, vГ nhiб»Ғu hЖЎn nб»Ҝa.В

Trong quГЈng thб»қi gian trЖ°б»ӣc Д‘Гі, Гҙng Д‘ГЈ tб»«ng lГ GiбәЈng viГӘn Cao cбәҘp tбәЎi TrЖ°б»қng QuбәЈn trб»Ӣ Sloan của MIT, mб»ҷt lГЈnh Д‘бәЎo cбәҘp cao của Oracle, vГ mб»ҷt chuyГӘn gia quб»‘c gia của LiГӘn minh ChГўu ГӮu.

Trong buб»•i trГІ chuyб»Үn nГ y, chГәng ta Д‘ГЈ thбәЈo luбәӯn vб»Ғ cГЎch mГ TrГӯ tuб»Ү NhГўn tбәЎo cГі thб»ғ trб»ҹ thГ nh mб»ҷt mб»‘i Д‘e dб»Қa tб»“n tбәЎi Д‘б»‘i vб»ӣi loГ i ngЖ°б»қi, lГҪ do tбәЎi sao nhб»Ҝng lб»қi bГЎo Д‘б»ҷng vб»Ғ rủi ro tб»“n tбәЎi mГ chГәng ta thбәҘy trГӘn phЖ°ЖЎng tiб»Үn truyб»Ғn thГҙng hiб»Үn Д‘бәЎi thЖ°б»қng cГІn non nб»ӣt vГ khГҙng mang lбәЎi lб»Јi Гӯch, cЕ©ng nhЖ° cГЎch mГ rủi ro tб»« AI tЖ°ЖЎng tГЎc vб»ӣi nhб»Ҝng hГ¬nh thб»©c rủi ro hб»Ү thб»‘ng khГЎc mГ chГәng ta Д‘ang Д‘б»‘i diб»Үn.В

ChГәng ta cЕ©ng Д‘ГЈ nГіi vб»Ғ nguy cЖЎ bб»Ӣ kiб»ғm soГЎt bб»ҹi cГЎc quy Д‘б»Ӣnh vб»ӣi AI, cГЎch tiбәҝp cбәӯn tб»‘t nhбәҘt Д‘б»ғ quy Д‘б»Ӣnh AI vГ phГЎp luбәӯt, cЕ©ng nhЖ° nhiб»Ғu Д‘iб»ғm khГЎc nб»Ҝa.

Nбәҝu bбәЎn thГӯch tбәӯp nГ y, hГЈy chбәҜc chбәҜn Д‘б»ғ lбәЎi ГҪ kiбәҝn của bбәЎn trong phбә§n bГ¬nh luбәӯn, trГӘn cГЎc mбәЎng xГЈ hб»ҷi hoбә·c bбәҘt cб»© nЖЎi nГ o khГЎc. VГ bГўy giб»қ, chГәng ta sбәҪ bбәҜt Д‘бә§u vб»ӣi tбәӯp phГЎt sГіng hГҙm nay. ChГ o Trond, rбәҘt vui gбә·p Д‘Ж°б»Јc bбәЎn trГӘn chЖ°ЖЎng trГ¬nh.

Trond Arne Undheim: TГҙi cЕ©ng rбәҘt hб»©ng thГә. CбәЈm ЖЎn bбәЎn rбәҘt nhiб»Ғu vГ¬ Д‘ГЈ mб»қi tГҙi.

Adel Nehme: Vбәӯy Д‘б»ғ chuбә©n bб»Ӣ cho cuб»ҷc trao Д‘б»•i hГҙm nay, liб»Үu cГі phбәЈi trГӯ tuб»Ү nhГўn tбәЎo hiб»Үn nay Д‘ang lГ mб»ҷt rủi ro tб»“n tбәЎi Д‘б»‘i vб»ӣi nhГўn loбәЎi khГҙng?

Trond Arne Undheim: CГі vГ khГҙng. Hiб»Үn tбәЎi Д‘ГЈ cГі nhб»Ҝng Д‘iб»Ғu chГәng ta nhбәҘt Д‘б»Ӣnh cбә§n lo lбәҜng. Khi chГәng ta bбәҜt Д‘бә§u lo lбәҜng thГ¬ vбәҘn Д‘б»Ғ sбәҪ khГҙng tб»ұ dЖ°ng biбәҝn mбәҘt VГ¬ vбәӯy, chГәng ta phбәЈi lo lбәҜng tб»« bГўy giб»қ, ngay cбәЈ khi Д‘Гі chб»ү lГ mб»ҷt rủi ro trong tЖ°ЖЎng lai, nГі nhбәҘt Д‘б»Ӣnh sбәҪ trб»ҹ thГ nh mб»ҷt rủi ro rбәҘt nghiГӘm trб»Қng nбәҝu chГәng ta khГҙng xб»ӯ lГҪ tб»‘t nГі, nhЖ°ng tГҙi nghД© cuб»ҷc thбәЈo luбәӯn hiб»Үn tбәЎi Д‘ang Д‘Ж°б»Јc phГҙ trЖ°ЖЎng quГЎ mб»©c.

Hiб»Үn tбәЎi vбә«n chЖ°a cГі dбәҘu hiб»Үu nГ o cho thбәҘy AI sбәҪ tiбәҝp quбәЈn vб»Ӣ trГӯ của chГәng ta trong tЖ°ЖЎng lai gбә§n, vГ Д‘Гўy chЖ°a phбәЈi lГ thб»қi Д‘iб»ғm Д‘ГЎng bГЎo Д‘б»ҷng. DГ№ Д‘Гўy lГ thб»қi Д‘iб»ғm Д‘б»‘i mбә·t vб»ӣi mб»‘i Д‘e dб»Қa tб»“n tбәЎi, tuy nhiГӘn, lГ ngЖ°б»қi nghiГӘn cб»©u vб»Ғ nhб»Ҝng mб»‘i Д‘e dб»Қa Д‘Гі, tГҙi khГҙng nghД© Д‘бәҝn nДғm vГ thГЎng nГ o Д‘Гі AI sбәҪ chiбәҝm Д‘oбәЎt theo bбәҘt kб»і hГ¬nh thб»©c nГ o Д‘б»ғ chГәng ta cГі thб»ғ thбәЈo luбәӯn.

AI sбәҪ khГҙng Д‘e dб»Қa Д‘бәҝn con ngЖ°б»қi nбәҝu sб»ӯ dб»Ҙng Д‘Гәng cГЎch

Adel Nehme: ДҗГәng, chГәng ta nhбәҘt Д‘б»Ӣnh sбәҪ thбәЈo luбәӯn vб»Ғ Д‘iб»Ғu Д‘Гі vГ bГ n thбәЈo vб»Ғ cГЎch bбәЎn nhГ¬n nhбәӯn vб»Ғ rủi ro tб»“n tбәЎi tб»« sб»ұ phГЎt triб»ғn của trГӯ tuб»Ү nhГўn tбәЎo theo thб»қi gian. VГ¬ vбәӯy, tГҙi rбәҘt hб»©ng thГә Д‘б»ғ nГіi chuyб»Үn vб»ӣi bбәЎn vб»Ғ Д‘iб»Ғu nГ y vГ¬ hiб»Үn tбәЎi bбәЎn Д‘ang dбә«n dбәҜt mб»ҷt nghiГӘn cб»©u tбәЎi ДҗбәЎi hб»Қc Stanford vб»Ғ Д‘iб»Ғu bбәЎn mГҙ tбәЈ lГ nghiГӘn cб»©u vб»Ғ rủi ro lan truyб»Ғn, chГәng ta sбәҪ nГіi sГўu hЖЎn vб»Ғ nГі vГ vб»Ғ nhб»Ҝng rủi ro hб»Ү thб»‘ng tб»“n tбәЎi liГӘn quan Д‘бәҝn Д‘Гі.

NhЖ°ng cГі thб»ғ trЖ°б»ӣc hбәҝt, hГЈy giГәp chГәng tГҙi hiб»ғu rГө hЖЎn vб»Ғ nб»ҷi dung của nghiГӘn cб»©u vГ Д‘б»ҷng cЖЎ Д‘бәұng sau nghiГӘn cб»©u.

Trond Arne Undheim: ChбәҜc chбәҜn, khГЎi niб»Үm vб»Ғ rủi ro lan truyб»Ғn lГ mб»ҷt phГ©p бә©n dб»Ҙ, rГө rГ ng lГ vбәӯy, nhЖ°ng cГЎch Д‘ЖЎn giбәЈn nhбәҘt Д‘б»ғ nghД© vб»Ғ nГі lГ nghД© Д‘бәҝn mб»ҷt dГІng nЖ°б»ӣc hoбә·c bбәЎn cГі thб»ғ nghД© Д‘бәҝn mб»ҷt thГЎc nЖ°б»ӣc. BбәЎn thбәӯm chГӯ cГі thб»ғ nghД© Д‘бәҝn mб»ҷt con sГҙng vГ mб»ҷt Д‘б»“ng bбәұng sГҙng. VГ tГҙi sб»ӯ dб»Ҙng sГҙng Amazon Д‘б»ғ minh hб»Қa Д‘iб»Ғu Д‘Гі vГ¬ cГі rбәҘt nhiб»Ғu sГҙng con, nhЖ°ng бәЈnh hЖ°б»ҹng của toГ n bб»ҷ hб»Ү thб»‘ng lГ kбәҝch sГ n.

NГі бәЈnh hЖ°б»ҹng Д‘бәҝn mб»ҷt phбә§n lб»ӣn của lб»Ҙc Д‘б»Ӣa Д‘Гі vГ nhiб»Ғu hЖЎn nб»Ҝa. VГ¬ vбәӯy, Д‘Гі lГ nЖЎi mГ ГҪ tЖ°б»ҹng vб»Ғ lan truyб»Ғn Д‘бәҝn. Dб»ұ ГЎn của chГәng tГҙi nhГ¬n vГ o tЖ°ЖЎng lai 50 nДғm tб»ӣi. ChГәng tГҙi Д‘ГЈ tбәЎo ra nДғm kб»Ӣch bбәЈn. VГ chб»ү Д‘б»ғ nhбәҜc nhб»ҹ, kб»Ӣch bбәЈn lГ nhб»Ҝng ГҪ tЖ°б»ҹng vГ khГЎi niб»Үm cГі thб»ғ xбәЈy ra trong tЖ°ЖЎng lai. VГ luГҙn cГі nhiб»Ғu lб»ұa chб»Қn, nГӘn chГәng tГҙi chб»Қn nДғm, cГі thб»ғ lГ ba hoбә·c mЖ°б»қi lДғm trДғm kб»Ӣch bбәЈn khГЎc nhau, bбәЎn khГҙng bao giб»қ cГі thб»ғ dб»ұ Д‘oГЎn chГӯnh xГЎc Д‘iб»Ғu gГ¬ sбәҪ xбәЈy ra.

NГі бәЈnh hЖ°б»ҹng Д‘бәҝn mб»ҷt phбә§n lб»ӣn của lб»Ҙc Д‘б»Ӣa Д‘Гі vГ nhiб»Ғu hЖЎn nб»Ҝa. VГ¬ vбәӯy, Д‘Гі lГ nЖЎi mГ ГҪ tЖ°б»ҹng vб»Ғ lan truyб»Ғn Д‘бәҝn. Dб»ұ ГЎn của chГәng tГҙi nhГ¬n vГ o tЖ°ЖЎng lai 50 nДғm tб»ӣi. ChГәng tГҙi Д‘ГЈ tбәЎo ra nДғm kб»Ӣch bбәЈn. VГ chб»ү Д‘б»ғ nhбәҜc nhб»ҹ, kб»Ӣch bбәЈn lГ nhб»Ҝng ГҪ tЖ°б»ҹng vГ khГЎi niб»Үm cГі thб»ғ xбәЈy ra trong tЖ°ЖЎng lai. VГ luГҙn cГі nhiб»Ғu lб»ұa chб»Қn, nГӘn chГәng tГҙi chб»Қn nДғm, cГі thб»ғ lГ ba hoбә·c mЖ°б»қi lДғm trДғm kб»Ӣch bбәЈn khГЎc nhau, bбәЎn khГҙng bao giб»қ cГі thб»ғ dб»ұ Д‘oГЎn chГӯnh xГЎc Д‘iб»Ғu gГ¬ sбәҪ xбәЈy ra.

NhЖ°ng dб»ұ ГЎn của chГәng tГҙi lГ , chГәng tГҙi sб»ӯ dб»Ҙng tбәҘt cбәЈ cГЎc yбәҝu tб»‘ Д‘б»ҷng viГӘn, Д‘бә·c biб»Үt lГ yбәҝu tб»‘ Д‘б»ҷng viГӘn vб»Ғ cГҙng nghб»Ү, vГ chГәng tГҙi khГҙng chб»ү nhГ¬n vГ o tЖ°ЖЎng lai vГ Д‘б»‘i mбә·t vб»ӣi nhб»Ҝng rủi ro nГ o cГі thб»ғ xбәЈy ra, mГ chГәng tГҙi cГІn xem xГ©t cЖЎ hб»ҷi giбәЈm nhбә№ vГ Д‘бә·c biб»Үt trong gГіc nhГ¬n vб»Ғ lan truyб»Ғn nГ y, Д‘iб»Ғu quan trб»Қng lГ khГҙng nГӘn quГЎ say mГӘ vГ cГі thб»ғ bб»Ӣ mбәҜc kбә№t trong bбәҘt kб»і rủi ro cб»Ҙ thб»ғ nГ o, dГ№ nГі cГі vбә» lб»ӣn Д‘бәҝn Д‘Гўu.

Bб»ҹi vГ¬ bбәЎn cГі thб»ғ sai vб»Ғ cбәҘu hГ¬nh của rủi ro. VГ nбәҝu sau Д‘Гі bбәЎn Д‘бә§u tЖ° toГ n bб»ҷ thб»қi gian, tiб»Ғn bбәЎc vГ nДғng lЖ°б»Јng của mГ¬nh vГ o mб»ҷt rủi ro sai, Д‘бә·c biб»Үt lГ mб»ҷt hoбә·c hai rủi ro, vГ bбәЎn sai vб»Ғ Д‘iб»Ғu Д‘Гі. BГўy giб»қ, bбәЎn thбәӯm chГӯ Д‘ang Д‘бә·t cбәЈ nhГўn loбәЎi vГ o tГ¬nh thбәҝ rủi ro.

NativeX – Hб»Қc tiбәҝng Anh online toГ n diб»Үn “4 kб»№ nДғng ngГҙn ngб»Ҝ” cho ngЖ°б»қi Д‘i lГ m.

Vб»ӣi mГҙ hГ¬nh “Lб»ӣp Hб»Қc NГ©n” Д‘б»ҷc quyб»Ғn:

- TДғng hЖЎn 20 lбә§n chбәЎm “Д‘iб»ғm kiбәҝn thб»©c”, giГәp hiб»ғu sГўu vГ nhб»ӣ lГўu hЖЎn gбәҘp 5 lбә§n.

- TДғng khбәЈ nДғng tiбәҝp thu vГ tбәӯp trung qua cГЎc bГ i hб»Қc cГҙ Д‘б»Қng 3 – 5 phГәt.

- RГәt ngбәҜn gбә§n 400 giб»қ hб»Қc lГҪ thuyбәҝt, tДғng hЖЎn 200 giб»қ thб»ұc hГ nh.

- HЖЎn 10.000 hoбәЎt Д‘б»ҷng cбәЈi thiб»Үn 4 kб»№ nДғng ngoбәЎi ngб»Ҝ theo giГЎo trГ¬nh chuбә©n Quб»‘c tбәҝ tб»« National Geographic Learning vГ Macmillan Education.

Adel Nehme: Tuyб»Үt vб»қi! VГ bбәЎn Д‘ГЈ nГіi vб»Ғ viб»Үc chб»Қn lб»ұa 5 rủi ro. HГЈy giГәp chГәng tГҙi hiб»ғu rГө hЖЎn vб»Ғ nhб»Ҝng rủi ro nГ y lГ gГ¬ vГ lГ m sao bбәЎn Д‘ГЈ quyбәҝt Д‘б»Ӣnh chб»Қn 5 rủi ro cб»Ҙ thб»ғ nГ y khi thб»ұc hiб»Үn nghiГӘn cб»©u?

Trond Arne Undheim: б»Ә, tГҙi khГҙng bбәҜt Д‘бә§u vб»ӣi Д‘iб»Ғu Д‘Гі chб»ү vГ¬ toГ n bб»ҷ nghiГӘn cб»©u xoay quanh cГЎc lan truyб»Ғn. ChГәng tГҙi Д‘ГЈ chб»Қn 5 gГіc nhГ¬n nГ y, nhЖ°ng sau Д‘Гі, chГәng tГҙi tбәҘt nhiГӘn quay trб»ҹ lбәЎi vб»ӣi toГ n bб»ҷ logic phГўn chia nГ y, trong Д‘Гі mб»ҷt trong sб»‘ Д‘Гі lГ gГіc nhГ¬n vб»Ғ rủi ro khГӯ hбәӯu. VГ¬ vбәӯy, vб»ӣi tГҙi, rбәҘt quan trб»Қng khi cГі nДғm gГіc nhГ¬n nhЖ° vбәӯy vГ bГўy giб»қ tГҙi sбәҪ khГҙng liб»Үt kГӘ chГәng mб»ҷt cГЎch nhanh chГіng.

Vбәӯy lГ cГі mб»ҷt gГіc nhГ¬n vб»Ғ khГӯ hбәӯu. Mб»ҷt lГ vб»Ғ sб»ұ sб»Ҙp Д‘б»• tГ i chГӯnh. Mб»ҷt lГ vб»Ғ mб»ҷt kб»Ӣch bбәЈn chiбәҝn tranh thбәҝ giб»ӣi kiб»ғu cб»• Д‘iб»ғn. VГ¬ vбәӯy, nhЖ° mб»ҷt tб»ҷi Д‘б»“, nГі giб»‘ng nhЖ° lГ Д‘б»Ӣa chГӯnh trб»Ӣ. Sau Д‘Гі, chГәng ta cГі mб»ҷt tГ¬nh huб»‘ng sinh hб»Қc tб»•ng hб»Јp Д‘iГӘn Д‘бәЈo. VГ sau cГ№ng, chГәng ta cГі mб»ҷt kб»Ӣch bбәЈn rủi ro vб»Ғ TrГӯ tuб»Ү NhГўn tбәЎo, kб»Ӣch bбәЈn nбәҜm quyб»Ғn bб»ҹi TrГӯ tuб»Ү NhГўn tбәЎo, nhЖ°ng Д‘iб»Ғu quan trб»Қng lГ vб»ӣi tГҙi lГ trong mб»—i kб»Ӣch bбәЈn nГ y, mбә·c dГ№ cГі mб»ҷt yбәҝu tб»‘ chГӯnh, chГәng tГҙi chб»ү lГ m nhЖ° vбәӯy Д‘б»ғ bбәҜt Д‘бә§u.

NhЖ°ng toГ n bб»ҷ Д‘б»ҷng cЖЎ của nб»— lб»ұc thб»ұc sб»ұ lГ nhГ¬n vГ o mб»‘i liГӘn quan giб»Ҝa nhб»Ҝng yбәҝu tб»‘ nГ y vГ nhiб»Ғu, nhiб»Ғu yбәҝu tб»‘ khГЎc nб»Ҝa. NhЖ°ng Д‘iб»Ғu quan trб»Қng lГ chГәng tГҙi cГі nДғm kб»Ӣch bбәЈn khГЎc nhau cГі thб»ғ xбәЈy ra. VГ chГәng, hГЈy gб»Қi Д‘Гі lГ chủ yбәҝu Д‘Ж°б»Јc thГәc Д‘бә©y hoбә·c бәЈnh hЖ°б»ҹng chủ yбәҝu bб»ҹi mб»ҷt loбәЎi rủi ro hб»Ү thб»‘ng quan trб»Қng.

NhЖ°ng Д‘iб»Ғu rбәҘt quan trб»Қng lГ phбәЈi nГіi rбәұng cГі vбә» trГӯ thГҙng minh nhГўn tбәЎo lГ yбәҝu tб»‘ Д‘б»ҷng viГӘn, nhЖ°ng lГ hГ ng trДғm yбәҝu tб»‘ khГЎc xung quanh nГі Д‘ang бәЈnh hЖ°б»ҹng hoбә·c hГ¬nh thГ nh cГі lбәҪ trГӯ tuб»Ү nhГўn tбәЎo hoбә·c khГӯ hбәӯu mГ thб»ұc sб»ұ lГ yбәҝu tб»‘ Д‘б»ҷng viГӘn thб»ұc sб»ұ.

Adel Nehme: ДҗГәng vбәӯy, vГ bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp Д‘бәҝn sб»ұ tЖ°ЖЎng tГЎc giб»Ҝa cГЎc rủi ro vГ Д‘iб»Ғu mГ tГҙi thб»ұc sб»ұ thГӯch vб»Ғ cГЎch nghiГӘn cб»©u Д‘Ж°б»Јc xГўy dб»ұng lГ nГі Д‘бә·t cГЎc yбәҝu tб»‘ tГЎc Д‘б»ҷng rủi ro khГЎc nhau vГ o bб»‘i cбәЈnh của nhau. VГӯ dб»Ҙ, rủi ro tб»« TrГӯ tuб»Ү NhГўn tбәЎo khГҙng tб»“n tбәЎi Д‘б»ҷc lбәӯp trong mб»ҷt khГҙng gian trб»‘ng rб»—ng. NГі cГІn tб»“n tбәЎi trong ngб»Ҝ cбәЈnh của cГЎc rủi ro hб»Ү thб»‘ng khГЎc nhЖ°: Biбәҝn Д‘б»•i khГӯ hбәӯu, chiбәҝn tranh, nhЖ° bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp, sinh hб»Қc tб»•ng hб»Јp vГ nhiб»Ғu loбәЎi rủi ro khГЎc.

AI Д‘ang Д‘б»Ӣnh hГ¬nh lбәЎi thбәҝ giб»ӣi

Trond Arne Undheim: Vбәӯy nГӘn, toГ n bб»ҷ gГіc nhГ¬n liГӘn tiбәҝp Д‘бәҝn tб»« nghiГӘn cб»©u vб»Ғ thбәЈm hб»Қa, Д‘Гәng khГҙng, nЖЎi mГ nГі Д‘ГЈ Д‘Ж°б»Јc sб»ӯ dб»Ҙng mб»ҷt cГЎch rбәҘt thГ nh cГҙng Д‘б»ғ chб»ү ra rбәұng khi mб»ҷt thбәЈm hб»Қa tб»ұ nhiГӘn xбәЈy ra, vГ nhГўn tiб»Үn, Д‘Гўy lГ mб»ҷt cuб»ҷc thбәЈo luбәӯn lб»ӣn, tбәЎi sao gб»Қi nГі lГ tб»ұ nhiГӘn trong khi thб»ұc tбәҝ, Д‘Гі lГ mб»ҷt thбәЈm hб»Қa vДғn hГіa bб»ҹi vГ¬ tбәҘt cбәЈ nhб»Ҝng quyбәҝt Д‘б»Ӣnh chГәng ta Д‘Ж°a ra chГӯnh lГ nguyГӘn nhГўn tбәЎo ra nhб»Ҝng thбәЈm hб»Қa Д‘Гі.

ДҗГі lГ mб»ҷt cuб»ҷc thбәЈo luбәӯn hoГ n toГ n khГЎc. NhЖ°ng dГ№ sao, khi nhГ¬n vГ o nhб»Ҝng sб»ұ kiб»Үn liГӘn tiбәҝp, nбәҝu chб»ү xem xГ©t mб»ҷt thбәЈm hб»Қa tб»ұ nhiГӘn hoбә·c mб»ҷt tai nбәЎn do thiГӘn nhiГӘn gГўy ra, rбәҘt rГө rГ ng rбәұng khГҙng chб»ү cГі mб»ҷt sб»ұ kiб»Үn Д‘ЖЎn lбә» xбәЈy ra mГ mб»—i sб»ұ kiб»Үn lбәЎi dбә«n Д‘бәҝn sб»ұ kiб»Үn tiбәҝp theo. Mб»ҷt trбәӯn lб»Ҙt cГі thб»ғ dбә«n Д‘бәҝn sб»ұ sб»Ҙp Д‘б»• của hб»Ү thб»‘ng Д‘iб»Үn vГ suy giбәЈm cЖЎ sб»ҹ hбәЎ tбә§ng của con ngЖ°б»қi vГ nhб»Ҝng vбәҘn Д‘б»Ғ tЖ°ЖЎng tб»ұ.

VГ¬ vбәӯy, nГі Д‘ГЈ lГ mб»ҷt cГҙng cб»Ҙ chГәng tГҙi Д‘ГЈ sб»ӯ dб»Ҙng trong lД©nh vб»ұc nghiГӘn cб»©u hoбә·c trong cб»ҷng Д‘б»“ng chuyГӘn gia vб»Ғ thбәЈm hб»Қa Д‘б»ғ tб»• chб»©c cГЎc nб»— lб»ұc cб»©u trб»Ј, vГ chб»ү cбә§n nhГ¬n vГ o nhб»Ҝng gГ¬ cГі thб»ғ xбәЈy ra tiбәҝp theo vГ Д‘iб»Ғu gГ¬ thЖ°б»қng cбә§n Д‘Ж°б»Јc di Д‘б»ҷng hГіa Д‘б»ғ cб»©u giГәp nhб»Ҝng ngЖ°б»қi trong nhб»Ҝng tГ¬nh huб»‘ng khбә©n cбәҘp nhЖ° vбәӯy. BГўy giб»қ, nhб»Ҝng бәЈnh hЖ°б»ҹng liГӘn tiбәҝp rб»ҷng lб»ӣn mГ chГәng tГҙi Д‘ang nГіi Д‘бәҝn trong nghiГӘn cб»©u của mГ¬nh, chГәng trбәЈi rб»ҷng hЖЎn nhiб»Ғu, vГ¬ vбәӯy chГәng, chГәng khГҙng nhбәҘt thiбәҝt phбәЈi liГӘn quan Д‘бәҝn mб»ҷt sб»ұ kiб»Үn cб»Ҙ thб»ғ, mГ liГӘn quan Д‘бәҝn viб»Үc xГЈ hб»ҷi lГ mб»ҷt thб»ғ thб»‘ng nhбәҘt, Д‘Гәng khГҙng?

NГі bao gб»“m rбәҘt nhiб»Ғu hб»Ү thб»‘ng khГЎc nhau, cГі thб»ғ nГіi lГ nhЖ° vбәӯy. VГ chГәng ta xб»ӯ lГҪ rбәҘt kГ©m tбәҘt cбәЈ nhб»Ҝng hб»Ү thб»‘ng nГ y. Дҗa sб»‘ chГәng ta thб»ұc sб»ұ khГҙng nghД© theo cГЎch hб»Ү thб»‘ng. Дҗб»‘i vб»ӣi con ngЖ°б»қi, viб»Үc suy nghД© theo cГЎch hб»Ү thб»‘ng khГҙng hб»Ғ dб»… dГ ng. VГ khГЎi niб»Үm vб»Ғ sб»ұ lan truyб»Ғn liГӘn tiбәҝp giГәp chГәng ta lГ m Д‘iб»Ғu Д‘Гі. VГ¬ chГәng ta cГі thб»ғ cб»‘ gбәҜng cГҙ lбәӯp mб»ҷt sб»‘ yбәҝu tб»‘ Д‘Гі vГ sau Д‘Гі chГәng ta cГі thб»ғ xГЎc Д‘б»Ӣnh.

Trong trЖ°б»қng hб»Јp nГ y, chГәng ta cбә§n tбәӯp trung vГ o Д‘iб»Ғu gГ¬ vГ sau Д‘Гі cГі thб»ғ lГ Д‘iб»Ғu gГ¬ chГәng ta muб»‘n tбәӯp trung tiбәҝp theo. Tuy nhiГӘn, hб»Ү thб»‘ng lб»ӣn của cГЎc hб»Ү thб»‘ng Д‘Ж°a chГәng ta nhanh chГіng vГ o lГҪ thuyбәҝt phб»©c tбәЎp vГ trб»ҹ nГӘn rбәҘt khГі kiб»ғm soГЎt vб»ӣi hбә§u hбәҝt cГЎc phЖ°ЖЎng phГЎp khoa hб»Қc truyб»Ғn thб»‘ng, mГ dб»ұa trГӘn viб»Үc cГҙ lбәӯp mб»Қi thб»© Д‘бәҝn tб»«ng chi tiбәҝt nhб»Ҹ nhбәҘt vГ sau Д‘Гі trб»ҹ thГ nh chuyГӘn gia trong khГӯa cбәЎnh Д‘Гі.

TГҙi nghД© Д‘Гўy chГӯnh lГ thГЎch thб»©c của mГҙ hГ¬nh nГ y, lГ nГі Д‘бә·t ra thГЎch thб»©c sГўu rб»ҷng Д‘б»‘i vб»ӣi khoa hб»Қc vГ kб»№ thuбәӯt, mГ truyб»Ғn thб»‘ng khГҙng thб»ғ xб»ӯ lГҪ loбәЎi phб»©c tбәЎp nГ y hoбә·c chб»Қn cГЎch xб»ӯ lГҪ bбәұng cГЎch chia nhб»Ҹ nГі. NhЖ°ng б»ҹ Д‘Гўy, Д‘iб»ғm quan trб»Қng lГ , nбәҝu bбәЎn chia nhб»Ҹ nГі, bбәЎn sбәҪ mбәҘt cбәЈ bб»©c tranh toГ n bб»ҷ, vГ Д‘Гі lГ Д‘iб»Ғu quan trб»Қng.

ДҗГі lГ mб»ҷt cГҙng cб»Ҙ rбәҘt, rбәҘt khГі khДғn Д‘б»ғ sб»ӯ dб»Ҙng. NhЖ°ng nГі liГӘn quan Д‘бәҝn rбәҘt nhiб»Ғu Д‘iб»Ғu hЖЎn lГ nhб»Ҝng thбәЈm hб»Қa vГ nhб»Ҝng Д‘iб»Ғu rбәҘt dб»… nhГ¬n thбәҘy. NГі cЕ©ng bao gб»“m nhiб»Ғu Д‘бә·c Д‘iб»ғm khГҙng thб»ғ nhГ¬n thбәҘy Д‘Ж°б»Јc. VГ khi chГәng ta nГіi vб»Ғ TrГӯ tuб»Ү NhГўn tбәЎo cб»Ҙ thб»ғ, hГЈy thбәЈo luбәӯn vб»Ғ mб»ҷt sб»‘ chi tiбәҝt của TrГӯ tuб»Ү NhГўn tбәЎo.

Adel Nehme: ДҗГәng vбәӯy, vГ hГЈy bбәҜt Д‘бә§u tб»« Д‘Гі, mб»ҷt trong nhб»Ҝng rủi ro chГӯnh mГ bбәЎn bГ n luбәӯn trong NghiГӘn cб»©u Rủi ro LiГӘn tiбәҝp lГ rủi ro tб»« TrГӯ tuб»Ү NhГўn tбәЎo trб»ҹ nГӘn khГҙng kiб»ғm soГЎt, Д‘Гі chГӯnh lГ Д‘iб»Ғu mГ tГҙi muб»‘n tбәӯp trung vГ o trong tбәӯp phim hГҙm nay. BбәЎn biбәҝt Д‘бәҘy, tГҙi nghД© nhiб»Ғu ngЖ°б»қi trong ngГ nh cГҙng nghiб»Үp, bбәЈn thГўn tГҙi cЕ©ng vбәӯy, Д‘б»Ғu lбәЎc quan khi nГіi Д‘бәҝn TrГӯ tuб»Ү NhГўn tбәЎo.

NГіi vб»Ғ bбәЈn thГўn tГҙi б»ҹ Д‘Гўy, tГҙi khГҙng nghД© mГ¬nh cГі sб»ұ hiб»ғu biбәҝt hay khбәЈ nДғng nбәҜm bбәҜt đủ mбәЎnh mбәҪ vб»Ғ cГЎch TrГӯ tuб»Ү NhГўn tбәЎo cГі thб»ғ trб»ҹ thГ nh mб»ҷt mб»‘i Д‘e dб»Қa tб»“n tбәЎi Д‘б»‘i vб»ӣi loГ i ngЖ°б»қi. Дҗб»ғ lГ m rГө, tГҙi nghД© rбәұng cГі nhб»Ҝng vбәҘn Д‘б»Ғ cбәҘp bГЎch mГ chГәng ta cбә§n phбәЈi khбәҜc phб»Ҙc vб»ӣi TrГӯ tuб»Ү NhГўn tбәЎo. VГӯ dб»Ҙ nhЖ° duy trГ¬ Д‘б»ҷ chб»Үch, khuбәҝch Д‘бәЎi thГҙng tin sai lб»Үch, sб»ұ suy giбәЈm chбәҘt lЖ°б»Јng của internet khi mб»Қi thб»© Д‘Ж°б»Јc tб»ұ Д‘б»ҷng tбәЎo ra, hoбә·c viб»Үc cГЎc tГЎc nhГўn xбәҘu lбәЎm dб»Ҙng AI.

NhЖ°ng tГҙi gбә·p khГі khДғn khi tЖ°б»ҹng tЖ°б»Јng lГ m thбәҝ nГ o TrГӯ tuб»Ү NhГўn tбәЎo trб»ҹ nГӘn khГҙng kiб»ғm soГЎt trong thб»ұc tбәҝ. VГ tГҙi nghД© Д‘бәҝn viб»Үc sб»ӯ dб»Ҙng gГіc nhГ¬n vб»Ғ rủi ro liГӘn tiбәҝp, khi tГҙi bбәҜt Д‘бә§u nghiГӘn cб»©u, cб»‘ gбәҜng hiб»ғu sГўu hЖЎn vГ chuбә©n bб»Ӣ cho tбәӯp nГ y, thб»ұc sб»ұ Д‘ГЈ mang lбәЎi cho tГҙi mб»ҷt cГЎch tб»‘t Д‘б»ғ xГўy dб»ұng tЖ°б»ҹng tЖ°б»Јng Д‘Гі. Vбәӯy nГӘn cГі thб»ғ bбәЎn hГЈy chб»ү dбә«n chГәng tГҙi qua cГЎc kб»Ӣch bбәЈn mГ bбәЎn Д‘ГЈ suy nghД© sГўu khi nГіi Д‘бәҝn TrГӯ tuб»Ү NhГўn tбәЎo khГҙng kiб»ғm soГЎt, vГ bбәЎn nghД© gГ¬ lГ Д‘iб»Ғu cбә§n phбәЈi xбәЈy ra Д‘б»ғ TrГӯ tuб»Ү NhГўn tбәЎo trб»ҹ thГ nh hiб»Үn thб»ұc?

Trond Arne Undheim: ChбәҜc chбәҜn. Дҗб»ғ tГҙi nГіi trЖ°б»ӣc tiГӘn rбәұng tГҙi khГЎ hoГ i nghi vб»Ғ toГ n bб»ҷ khГЎi niб»Үm vб»Ғ TrГӯ tuб»Ү NhГўn tбәЎo khГҙng kiб»ғm soГЎt. TГҙi xem Д‘Гі lГ khГЎ khГі Д‘б»ғ xбәЈy ra, nhЖ°ng tГҙi nghД© cГЎch duy nhбәҘt mГ chГәng ta cГі thб»ғ hiб»ғu vб»Ғ nГі ngГ y nay lГ hiб»Үn tЖ°б»Јng mГ trong Д‘Гі cГі sб»ұ kбәҝt hб»Јp giб»Ҝa cГЎc tГЎc Д‘б»ҷng rбәҘt thб»ұc tбәҝ, rГө rГ ng của con ngЖ°б»қi. ChГәng cГі thб»ғ lГ chГӯnh phủ hoбә·c cГЎc phбә§n tб»ӯ trong chГӯnh phủ.

ChГәng cГі thб»ғ lГ nhб»Ҝng ngЖ°б»қi vГ nhГіm cГі ГҪ Д‘б»Ӣnh tб»‘t, Д‘Гәng Д‘бәҜn, nhЖ°ng tбәҘt nhiГӘn cЕ©ng cГі nhб»Ҝng thб»ұc thб»ғ cГі ГҪ Д‘б»Ӣnh xбәҘu, nhЖ° cГЎc nhГіm khủng bб»‘, cГі lбәҪ lГ cГЎc mбәЎng lЖ°б»ӣi tб»ҷi phбәЎm lб»ӣn hoбә·c cГЎc nhГіm nhГ khoa hб»Қc Д‘iГӘn rб»“ chб»ү muб»‘n, hoбә·c thбәӯm chГӯ lГ cГЎc cГҙng ty chб»ү muб»‘n Д‘бә©y mбәЎnh biГӘn giб»ӣi vГ muб»‘n phГЎt triб»ғn nhб»Ҝng thб»©, vГ hб»Қ cГі ГҪ tЖ°б»ҹng nГ y, Д‘iб»Ғu mГ chГәng ta cбә§n thбәЈo luбәӯn vб»Ғ sб»ұ Д‘б»•i mб»ӣi liГӘn quan Д‘бәҝn cГҙng lГҪ.

Mб»—i khi tГҙi thб»ұc hiб»Үn mб»ҷt hГ nh Д‘б»ҷng Д‘iГӘn rб»“, tГҙi coi Д‘Гі lГ sб»ұ Д‘б»•i mб»ӣi, Д‘iб»Ғu mГ chГәng ta cбә§n phбәЈi trГЎnh. Tuy nhiГӘn, trong tГўm trГӯ tГҙi, dГІng sб»ұ kiб»Үn cГі thб»ғ giбәЈi thГӯch vб»Ғ TrГӯ tuб»Ү NhГўn tбәЎo trб»ҹ nГӘn khГҙng kiб»ғm soГЎt, cГі nghД©a lГ nГі бәЈnh hЖ°б»ҹng Д‘бәҝn rбәҘt nhiб»Ғu yбәҝu tб»‘ khГЎc. TГҙi nghД©, khГҙng phбәЈi mб»ҷt hб»Ү thб»‘ng TrГӯ thГҙng minh NhГўn tбәЎo nГ o Д‘Гі tб»ұ quyбәҝt Д‘б»Ӣnh sбәҪ chiбәҝm lбәҘy thбәҝ giб»ӣi. TГҙi nghД© rбәұng Д‘Гі thб»ұc sб»ұ lГ mб»ҷt cГЎch quГЎ Д‘ЖЎn giбәЈn Д‘б»ғ nhГ¬n vГ o bбәҘt kб»і loбәЎi quбәЈn trб»Ӣ hoбә·c thay Д‘б»•i nГ o; khi cГЎc cuб»ҷc cГЎch mбәЎng diб»…n ra, chГәng khГҙng phбәЈi vГ¬ mб»ҷt ngЖ°б»қi Д‘ГЈ quyбәҝt Д‘б»Ӣnh Д‘iб»Ғu gГ¬ Д‘Гі sбәҪ xбәЈy ra.

ДҗГі lГ sб»ұ kбәҝt hб»Јp của nhiб»Ғu yбәҝu tб»‘ vГ vб»Ӣ trГӯ khГЎc nhau. VГ¬ vбәӯy, trong lб»Ӣch sб»ӯ của loГ i ngЖ°б»қi, khГҙng cГі sб»ұ thay Д‘б»•i nГ o xбәЈy ra chб»ү vГ¬ mб»ҷt yбәҝu tб»‘ nГ o Д‘Гі can thiб»Үp, hoбә·c mб»ҷt Д‘б»‘i tЖ°б»Јng, hoбә·c mб»ҷt cГҙng nghб»Ү hay mб»ҷt sб»ұ kiб»Үn Д‘ЖЎn lбә». ДҗГі lГ sб»ұ kбәҝt hб»Јp của rбәҘt nhiб»Ғu yбәҝu tб»‘ khГЎc nhau. Vбәӯy nГӘn, chГәng ta khГҙng cбә§n lo ngбәЎi chб»ү mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі sбәҪ xбәЈy ra sai.

CГі hГ ng trДғm ngГ n Д‘iб»Ғu phбәЈi xбәЈy ra sai sГіt. Trong khoбәЈng thб»қi gian ngбәҜn Д‘Гі, cГі lбәҪ nГі sбәҪ trб»ҹ thГ nh mб»ҷt kбә» thГ№ kбәҝt hб»Јp vГ trong trЖ°б»қng hб»Јp của TrГӯ tuб»Ү NhГўn tбәЎo, nГі cГ ng trб»ҹ nГӘn quan trб»Қng khi chГәng ta Д‘ГЈ tГӯch hб»Јp cГҙng nghб»Ү tiГӘn tiбәҝn vГ o cГЎc thủ tб»Ҙc chГӯnh phủ, trong cГЎc nб»— lб»ұc vГ sбәЈn phбә©m của khu vб»ұc tЖ° nhГўn, nhб»Ҝng thб»© Д‘ang trб»ҹ thГ nh cГЎc cГҙng nghб»Ү nб»Ғn tбәЈng.

ChГәng rбәҘt khГі Д‘б»ғ loбәЎi bб»Ҹ. chГәng tГҙi thбәӯm chГӯ khГҙng đủ khбәЈ nДғng Д‘б»ғ loбәЎi bб»Ҹ chГәng. CГі thб»ғ chГәng ta thбәӯm chГӯ khГҙng thб»ғ loбәЎi bб»Ҹ chГәng nбәҝu chГәng ta muб»‘n. Nбәҝu chГәng ta Д‘б»“ng ГҪ loбәЎi bб»Ҹ chГәng, cГі thб»ғ mбәҘt 25 nДғm vГ cГі thб»ғ Д‘Ж°a chГәng ta trб»ҹ lбәЎi mб»ҷt Д‘iб»ғm mГ vДғn minh hoбә·c tГ i chГӯnh sбәҪ bб»Ӣ Д‘бә©y lГ№i, gГўy ra suy thoГЎi vГ suy giбәЈm kinh tбәҝ, hoбә·c thбәӯm chГӯ lГ Д‘iб»Ғu tб»“i tб»Ү hЖЎn.

Vбәӯy nГӘn, tГҙi nghД© Д‘iб»Ғu quan trб»Қng б»ҹ Д‘Гўy lГ hГЈy cбә©n thбәӯn khi bбәЎn trб»ҹ nГӘn phб»Ҙ thuб»ҷc vГ o mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі, bб»ҹi vГ¬ cГі thб»ғ bбәЎn sбәҪ khГҙng thб»ғ xГіa bб»Ҹ nГі. Дҗiб»Ғu nГ y thб»ұc sб»ұ lГ mб»ҷt cГЎi gб»Қi lГ б»‘ng kГӯnh lan truyб»Ғn. VГ , trong tГ¬nh huб»‘ng Д‘Гі, chГәng ta nГіi vб»Ғ mб»ҷt kб»Ӣch bбәЈn Д‘Ж°б»Јc kГӯch thГӯch bб»ҹi sб»ұ kiб»Үn nЖЎi cГі mб»ҷt nhГіm cГЎc Д‘б»‘i tГЎc hб»Јp tГЎc vГ sб»ӯ dб»Ҙng trГӯ tuб»Ү nhГўn tбәЎo mб»ҷt cГЎch xбәҘu xa.

VГ tГҙi nghД© Д‘iб»Ғu Д‘Гі cГі thб»ғ xбәЈy ra.

Adel Nehme: GiбәЈi mГЈ mб»ҷt chГәt Д‘iб»Ғu bбәЎn Д‘б»Ғ cбәӯp б»ҹ Д‘Гўy, rбәұng bбәЎn cбә§n mб»ҷt trДғm yбәҝu tб»‘ khГЎc nhau vГ mб»ҷt trДғm quyбәҝt Д‘б»Ӣnh nhб»Ҹ, nhб»Ҝng quyбәҝt Д‘б»Ӣnh nhб»Ҹ Д‘Гі hГ¬nh thГ nh hЖ°б»ӣng Д‘i nguy hiб»ғm hЖЎn khi Д‘б»‘i mбә·t vб»ӣi nguy cЖЎ TrГӯ tuб»Ү NhГўn tбәЎo tб»ұ do trong tЖ°ЖЎng lai. TГҙi rбәҘt thГӯch cГЎch bбәЎn trГ¬nh bГ y Д‘iб»Ғu nГ y trong cuб»ҷc trГІ chuyб»Үn б»ҹ Д‘Гўy. Bб»ҹi vГ¬ nhб»Ҝng gГ¬ bбәЎn Д‘б»Ғ cбәӯp, vГӯ dб»Ҙ nhЖ° vб»Ғ viб»Үc TrГӯ tuб»Ү NhГўn tбәЎo trб»ҹ thГ nh mб»ҷt phбә§n khГҙng thб»ғ thiбәҝu vГ quan trб»Қng trong hбәЎ tбә§ng cЖЎ bбәЈn.

Khi bбәЎn nГіi vб»Ғ rủi ro tб»ұ do vГ o nДғm 2070, phбәЈi khГҙng? ChГәng ta cГі nhб»Ҝng quyбәҝt Д‘б»Ӣnh cГі lГҪ, quyбәҝt Д‘б»Ӣnh mГ chГәng ta cГі thб»ғ tбәҘt cбәЈ nghД© lГ cГі lГҪ phбәЈi khГҙng, nhб»Ҝng quyбәҝt Д‘б»Ӣnh mГ chГәng ta cГі thб»ғ Д‘Ж°a ra nhЖ° lГ mб»ҷt loГ i vГ o nhб»Ҝng thбәӯp kб»· 2030 vГ 40. VГ¬ vбәӯy, cГі thб»ғ bбәЎn hЖ°б»ӣng dбә«n chГәng tГҙi qua cГЎch bбәЎn nghД© lГ m thбәҝ nГ o trГӯ tuб»Ү nhГўn tбәЎo cГі thб»ғ trб»ҹ thГ nh mб»ҷt phбә§n của hбәЎ tбә§ng quan trб»Қng vГ nhб»Ҝng quyбәҝt Д‘б»Ӣnh cГі lГҪ Д‘Гі lГ gГ¬ khГҙng?

Nhб»Ҝng khбәЈ nДғng mГ chГәng ta cГі thб»ғ muб»‘n tбәӯn dб»Ҙng vб»ӣi trГӯ tuб»Ү nhГўn tбәЎo mбәЎnh mбәҪ hЖЎn trong vГІng 10 nДғm tб»ӣi. Nhб»Ҝng Д‘iб»Ғu Д‘Гі cГі vбә» nhЖ° cГі thб»ғ dбә«n chГәng ta Д‘бәҝn mб»ҷt vб»Ӣ trГӯ khГі khДғn hЖЎn trong tЖ°ЖЎng lai.

Trond Arne Undheim: ChГ , trЖ°б»ӣc hбәҝt, tГҙi khГҙng nghД© sб»ұ phГўn Д‘Гҙi giб»Ҝa AI vГ khГҙng cГі AI nГ y cГі ГҪ nghД©a gГ¬ cбәЈ. Дҗбә§u tiГӘn, trГӯ tuб»Ү nhГўn tбәЎo khГҙng phбәЈi lГ mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі duy nhбәҘt. ChГәng ta chЖ°a thбәЈo luбәӯn vб»Ғ cГЎch Д‘б»Ӣnh nghД©a nГі, nhЖ°ng bбәЎn biбәҝt Д‘бәҘy, AI chб»ү lГ , nГі chб»ү lГ mб»ҷt cГЎi tГӘn. NГі chб»ү lГ mб»ҷt thЖ°ЖЎng hiб»Үu tiбәҝp thб»Ӣ cho mб»ҷt loбәЎt cГЎc chб»©c nДғng khГЎc nhau Д‘ang liГӘn tб»Ҙc phГЎt triб»ғn.

Trong nДғm nay, Д‘Гі lГ mб»ҷt nДғm tuyб»Үt vб»қi cho mб»Қi ngЖ°б»қi khГЎm phГЎ cГЎc tГ№y chб»Қn trГІ chuyб»Үn. VГ Д‘б»ҷt nhiГӘn, mб»Қi ngЖ°б»қi phГЎt hiб»Үn ra cГЎc mГҙ hГ¬nh ngГҙn ngб»Ҝ lб»ӣn trЖ°б»ӣc Д‘Гі, Д‘ГЈ cГі trЖ°б»қng hб»Јp sб»ӯ dб»Ҙng hГ¬nh бәЈnh, mб»Қi ngЖ°б»қi hГ o hб»©ng vб»ӣi viб»Үc nhбәӯn diб»Үn hГ¬nh бәЈnh mГЁo vГ cГЎc thб»© khГЎc. ДҗГўy lГ nhб»Ҝng gГ¬ tГҙi gб»Қi lГ hiб»Үn tЖ°б»Јng phб»Ҙ, chГәng thб»ұc sб»ұ khГҙng phбәЈi lГ cб»‘t lГөi của nhб»Ҝng gГ¬ Д‘ang diб»…n ra.

Thб»ұc tбәҝ lГ , tб»« nhiб»Ғu thбәӯp kб»· nay, chГәng ta Д‘ГЈ tГӯch hб»Јp cГЎc thuбәӯt toГЎn sб»‘ hГіa vГ o quГЎ trГ¬nh ra quyбәҝt Д‘б»Ӣnh của chГӯnh phủ, hбәЎ tбә§ng vГ sбәЈn phбә©m tГ i chГӯnh, trong lД©nh vб»ұc giao thГҙng vбәӯn tбәЈi, thбәӯm chГӯ lГ trong tiГӘu dГ№ng, thЖ°ЖЎng mбәЎi Д‘iб»Үn tб»ӯ vГ nhiб»Ғu lД©nh vб»ұc khГЎc của cuб»ҷc sб»‘ng. VГ Д‘б»«ng quГӘn lД©nh vб»ұc sб»©c khб»Ҹe, Д‘Гәng khГҙng?

ChГәng ta chЖ°a Д‘i xa lбәҜm, nhЖ°ng ngГ y nay tГҙi nghД© rбәұng nГі khГЎ rГө rГ ng. Rбәұng б»©ng dб»Ҙng trong lД©nh vб»ұc sб»©c khб»Ҹe vГ Д‘б»«ng quГӘn б»©ng dб»Ҙng trong lД©nh vб»ұc mГҙi trЖ°б»қng, vб»ӣi tбәҘt cбәЈ cГЎc cбәЈm biбәҝn, tбәҘt cбәЈ dб»Ҝ liб»Үu mГ chГәng ta cГі thб»ғ thu thбәӯp tб»« mГҙi trЖ°б»қng sбәҪ trб»ҹ thГ nh quan trб»Қng. VГ¬ vбәӯy, chГәng ta Д‘б»‘i mбә·t vб»ӣi rбәҘt nhiб»Ғu thГЎch thб»©c lб»ӣn trong thбәҝ giб»ӣi của mГ¬nh.

б»һ Д‘Гі, chГәng ta sбәҪ phбәЈi dб»ұa vГ o cГЎc hб»Ү thб»‘ng thб»ұc sб»ұ Д‘ЖЎn giбәЈn hГіa, nhЖ°ng cГі thuбәӯt toГЎn tб»‘t hЖЎn, vГ trГӯ tuб»Ү nhГўn tбәЎo mang lбәЎi cho chГәng ta Д‘iб»Ғu Д‘Гі. VГ¬ vбәӯy, chГәng ta khГҙng cГі sб»ұ lб»ұa chб»Қn. ChГәng ta sбәҪ sб»ӯ dб»Ҙng tбәҘt cбәЈ nhб»Ҝng kб»№ thuбәӯt nГ y, nhЖ°ng chГәng ta phбәЈi giб»Ҝ tinh thбә§n cбәЈnh bГЎo. VГ theo tГҙi, Д‘iб»Ғu quan trб»Қng nhбәҘt lГ hб»Ү thб»‘ng quбәЈn trб»Ӣ của chГәng ta, cбәЈ trong lД©nh vб»ұc cГҙng vГ tЖ°, cбә§n phбәЈi trб»ҹ nГӘn linh hoбәЎt vГ phбәЈn б»©ng nhanh chГіng hЖЎn nhiб»Ғu.

Mб»Қi ngЖ°б»қi Д‘б»Ғu phбәЈi chб»Ӣu trГЎch nhiб»Үm. Nбәҝu bбәЎn lГ mб»ҷt nhГ cung cбәҘp, lГ mб»ҷt tб»• chб»©c chГӯnh phủ, nбәҝu bбәЎn бәЈnh hЖ°б»ҹng Д‘бәҝn hГ ng triб»Үu ngЖ°б»қi, Д‘Гі lГ mб»ҷt diб»…n viГӘn quбәЈn trб»Ӣ. BбәЎn Д‘ГЈ trб»ҹ thГ nh mб»ҷt chГӯnh phủ thб»ұc tбәҝ. BбәЎn phбәЈi nghiГӘm tГәc Д‘бәЈm nhбәӯn trГЎch nhiб»Үm Д‘Гі.

Adel Nehme: CГі Д‘iб»Ғu thГә vб»Ӣ khi bбәЎn nГіi vб»Ғ nhiб»Ғu quyбәҝt Д‘б»Ӣnh cГі lГҪ nГ y cГі thб»ғ dбә«n chГәng ta Д‘бәҝn rủi ro lГўu dГ i trong tЖ°ЖЎng lai vГ tбә§m quan trб»Қng của quбәЈn trб»Ӣ khi chГәng ta Д‘Ж°a ra nhб»Ҝng quyбәҝt Д‘б»Ӣnh nГ y, nghД© vб»Ғ viб»Үc tГӯch hб»Јp hб»Ү thб»‘ng sб»‘, trГӯ tuб»Ү nhГўn tбәЎo vГ o hбәЎ tбә§ng quan trб»Қng nhЖ°: ChДғm sГіc sб»©c khб»Ҹe, giao thГҙng, vГ cбәЈ nhб»Ҝng lД©nh vб»ұc khГЎc.

BбәЎn nghД© quбәЈn trб»Ӣ tб»‘t cбә§n phбәЈi lГ m nhЖ° thбәҝ nГ o ngay bГўy giб»қ? Hoбә·c trong vГІng 10 nДғm tб»ӣi khi chГәng ta phГЎt triб»ғn khбәЈ nДғng nГ y trong hбәЎ tбә§ng của mГ¬nh hЖЎn nб»Ҝa Д‘б»ғ trГЎnh rủi ro lГўu dГ i.

Trond Arne Undheim: LГҪ tЖ°б»ҹng nhбәҘt lГ quбәЈn trб»Ӣ của chГәng ta trong trЖ°б»қng hб»Јp cб»Ҙ thб»ғ nГ y lГ mб»ҷt hб»Ү thб»‘ng toГ n cбә§u. NhЖ°ng khi nhГ¬n vГ o khбәЈ nДғng thiбәҝt lбәӯp Д‘iб»Ғu Д‘Гі vГ sб»ұ khГЎng cб»ұ, cЕ©ng nhЖ° sб»ұ hiб»ғu biбәҝt vГ do dб»ұ Д‘б»‘i vб»ӣi Д‘iб»Ғu gГ¬ Д‘Гі nhЖ° vбәӯy, mб»ҷt khuГҙn khб»• toГ n diб»Үn, tГҙi nghД© nhб»Ҝng gГ¬ chГәng ta Д‘ang nghiГӘn cб»©u lГ cГЎc phЖ°ЖЎng phГЎp khu vб»ұc, nЖЎi cГЎc nб»Ғn kinh tбәҝ lб»ӣn, trong trЖ°б»қng hб»Јp nГ y, tГҙi nghД©, Д‘iб»Ғu chГәng ta thб»ұc sб»ұ quan tГўm lГ EU, Hoa Kб»і vГ Trung Quб»‘c Д‘ang thб»ұc hiб»Үn Д‘б»ғ quбәЈn lГҪ cГҙng nghб»Ү của hб»Қ vГ nhб»Ҝng cГҙng nghб»Ү Д‘ang Д‘Ж°б»Јc sб»ӯ dб»Ҙng Д‘Гі.

CГЎc lб»Ҙc Д‘б»Ӣa vГ hб»Ү thб»‘ng, ba tГЎc nhГўn nГ y \ phбәЈi hГ nh Д‘б»ҷng cГ№ng nhau vГ thб»ұc sб»ұ kбәҝt hб»Јp vб»ӣi nhau. Hб»Қ cбә§n phбәЈi cГ№ng nhau Д‘б»“ng thuбәӯn mб»ҷt sб»‘ nguyГӘn tбәҜc, khГҙng phбәЈi tбәҘt cбәЈ, tГҙi chбәҜc chбәҜn sбәҪ cГі ba hб»Ү thб»‘ng quy Д‘б»Ӣnh khГЎc nhau hoГ n toГ n, nhЖ°ng tГҙi nghД© Д‘iб»Ғu Д‘Гі sбәҪ phГЎt triб»ғn trong thбәӯp kб»· tб»ӣi.

VГ Д‘iб»Ғu thб»ұc sб»ұ quan trб»Қng lГ phбәЈi lГ m Д‘iб»Ғu Д‘Гі, tГҙi Д‘oГЎn, đủ nhanh, 10 nДғm nб»Ҝa. Sau Д‘Гі, bбәЎn cГі thб»ғ cГі mб»ҷt hб»Ү thб»‘ng thГӯch б»©ng cГі thб»ғ thay Д‘б»•i vГ linh hoбәЎt theo bбәҘt kб»і sб»ұ phГЎt triб»ғn nГ o Д‘ang hЖ°б»ӣng tб»ӣi chГәng ta, khГҙng chб»ү vб»Ғ AI, mГ cГІn vб»Ғ cГЎc thГЎch thб»©c rủi ro xбәҝp tбә§ng mГ chГәng ta sбәҪ phбәЈi Д‘б»‘i mбә·t vГ cГі thб»ғ kбәҝt hб»Јp viб»Үc bб»• sung nhiб»Ғu, rбәҘt nhiб»Ғu thб»© khГЎc cГЎc cГҙng nghб»Ү mб»ӣi nб»•i Д‘ang thб»ұc sб»ұ hoбәЎt Д‘б»ҷng trГӘn AI.

VГӯ dб»Ҙ, trong kб»Ӣch bбәЈn của tГҙi, cГҙng nghб»Ү lЖ°б»Јng tб»ӯ sбәҪ lГ yбәҝu tб»‘ Д‘бә©y mбәЎnh vГ lГ m cho mб»ҷt sб»‘ tГ¬nh huб»‘ng trб»ҹ nГӘn rбәҘt Д‘б»ҷt ngб»ҷt, nhЖ°ng cЕ©ng cГі khбәЈ nДғng rбәҘt tГӯch cб»ұc, chбәіng hбәЎn nhЖ° lЖ°б»Јng tГӯnh toГЎn bбәЎn cГі thб»ғ thб»ұc hiб»Үn qua mбәЎng sбәҪ thay Д‘б»•i Д‘ГЎng kб»ғ, vГ Д‘iб»Ғu Д‘Гі sбәҪ tбәЎo ra cГЎc б»©ng dб»Ҙng mб»ӣi, vГ¬ vбәӯy, tГҙi nghД©, chГәng ta phбәЈi tiбәҝp tб»Ҙc sГЎng tбәЎo vГ nбәҜm bбәҜt nhб»Ҝng cЖЎ hб»ҷi Д‘ang hiб»Үn ra vб»ӣi chГәng ta nhЖ° mб»ҷt loГ i ngЖ°б»қi, nhЖ° nhб»Ҝng ngЖ°б»қi sГЎng tбәЎo vГ nhЖ° chГӯnh phủ vГ nhб»Ҝng ngЖ°б»қi tham gia tЖ° nhГўn, nhЖ°ng chГәng ta phбәЈi cГі mб»ҷt hб»Ү thб»‘ng nЖЎi chГәng ta cб»‘ gбәҜng giб»Ҝ cho cГЎc hб»Ү thб»‘ng nГ y cГі thб»ғ giбәЈi thГӯch Д‘Ж°б»Јc.

ДҗГәng. VГ¬ vбәӯy, trГӯ tuб»Ү nhГўn tбәЎo cГі thб»ғ giбәЈi thГӯch Д‘Ж°б»Јc, cГЎc hб»Ү thб»‘ng cГі thб»ғ giбәЈi thГӯch Д‘Ж°б»Јc, vГ sau Д‘Гі, thб»© hai, lГ cГЎc hб»Ү thб»‘ng minh bбәЎch vГ sau Д‘Гі lГ cГі thб»ғ xГЎc minh. Minh bбәЎch vГ¬ chГәng Д‘Ж°б»Јc chuбә©n hГіa vГ dб»… hiб»ғu vГ Гӯt nhбәҘt lГ lГҪ thuyбәҝt cГі thб»ғ giao tiбәҝp vб»ӣi nhau. NhЖ°ng sau Д‘Гі, tГҙi cГІn mб»ҷt khГӯa cбәЎnh nб»Ҝa, vГ Д‘Гўy lбәЎi lГ mб»ҷt chГәt trГЎi vб»ӣi ГҪ tЖ°б»ҹng toГ n cбә§u, nhЖ°ng tГҙi Д‘ГЈ viбәҝt vб»Ғ Д‘iб»Ғu nГ y trong cuб»‘n sГЎch vб»Ғ cГҙng nghб»Ү y tбәҝ của mГ¬nh.

TГҙi nghД© Д‘Гі thб»ұc sб»ұ lГ mб»ҷt thГЎch thб»©c lб»ӣn khi Д‘бә·t tбәҘt cбәЈ niб»Ғm tin vГ o mб»ҷt nЖЎi. Hiб»Үn nay, chГәng ta cГі nhб»Ҝng hб»Ү thб»‘ng tiГӘn tiбәҝn, vГ tб»« mб»ҷt sб»‘ gГіc Д‘б»ҷ, viб»Үc chГәng ta khГҙng cГі mб»ҷt hб»Ү thб»‘ng toГ n cбә§u thб»ұc sб»ұ lГ tб»‘t. Internet thб»ұc sб»ұ mang lбәЎi mб»ҷt rủi ro. VГ¬ vбәӯy, nбәҝu viб»Үc Д‘ГЎnh sбәӯp mб»ҷt hб»Ү thб»‘ng cГі thб»ғ lГ m mбәҘt tбәҘt cбәЈ, may mбәҜn thay, Д‘iб»Ғu Д‘Гі khГҙng Д‘Гәng vб»ӣi internet.

AI cЕ©ng tб»“n tбәЎi rủi ro trong mГҙi trЖ°б»қng Internet

NhЖ°ng cГі thб»ғ cГЎc cГҙng nghб»Ү khГЎc sбәҪ dб»… dГ ng bб»Ӣ cГҙ lбәӯp. VГ¬ vбәӯy, tГҙi nghД© mб»ҷt trong nhб»Ҝng khГӯa cбәЎnh chГәng ta cбә§n xem xГ©t thб»ұc sб»ұ lГ cГі thб»ғ lГ m cho cГҙng nghб»Ү cб»Ҙ thб»ғ thГ nh khu vб»ұc vГ cГҙ lбәӯp mб»ҷt sб»‘ Д‘iб»Ғu Д‘б»ғ chГәng ta biбәҝt rбәұng nбәҝu mб»ҷt thбәЈm hб»Қa xбәЈy ra б»ҹ mб»ҷt phбә§n của mбәЎng lЖ°б»ӣi, nГі sбәҪ khГҙng lГ m sбәӯp toГ n bб»ҷ hб»Ү thб»‘ng hoбә·c cЖЎ sб»ҹ hбәЎ tбә§ng.В

VГ¬ khГҙng phбәЈi lГ cГі thб»ғ lГ m hủy diб»Үt mб»—i Д‘iб»ғm, nhЖ°ng cГі thб»ғ chб»ү lГ quГЎ Д‘бәҜt Д‘б»ғ xГўy dб»ұng lбәЎi vГ¬ nГі chб»ү hб»Јp lГҪ nбәҝu nhiб»Ғu bГӘn Д‘ГЈ Д‘бә§u tЖ° vГ o nГі. VГ¬ vбәӯy, nhб»Ҝng hб»Ү thб»‘ng chб»ү cГі ГҪ nghД©a khi vб»Ғ cЖЎ bбәЈn mб»Қi ngЖ°б»қi cГ№ng nhau, khi cГі vбәҘn Д‘б»Ғ xбәЈy ra trong nhб»Ҝng hб»Ү thб»‘ng Д‘Гі, cГі thб»ғ khГҙng Д‘ГЎng Д‘б»ғ xГўy dб»ұng lбәЎi chГәng.

Nбәҝu cГі mб»ҷt thбәЈm hб»Қa lб»ӣn. VГ¬ vбәӯy, tГҙi nghД© chГәng ta cбә§n xГўy dб»ұng cГЎc hб»Ү thб»‘ng mбәЎnh mбәҪ hЖЎn, cГі quy mГҙ б»ҹ mб»©c Д‘б»ҷ phГ№ hб»Јp vГ cГі thб»ғ Д‘Ж°б»Јc xГўy dб»ұng lбәЎi б»ҹ cбәҘp Д‘б»ҷ khu vб»ұc hoбә·c quб»‘c gia, hoбә·c thбәӯm chГӯ б»ҹ quy mГҙ nhб»Ҹ hЖЎn theo mб»ҷt cГЎch phГўn tГЎn. VГ xu hЖ°б»ӣng tбәӯp trung mГ chГәng ta Д‘ang thбәҘy trong nhiб»Ғu lД©nh vб»ұc trГӯ tuб»Ү nhГўn tбәЎo tб»« gГіc Д‘б»ҷ Д‘Гі, Д‘б»‘i vб»ӣi tГҙi, lГ khГЎ Д‘ГЎng sб»Ј.

Bб»ҹi vГ¬, cГЎc thuбәӯt toГЎn cГі thб»ғ linh hoбәЎt vГ cГі thб»ғ chбәЎy trГӘn cГЎc thiбәҝt bб»Ӣ nhб»Ҹ, nhЖ°ng cГЎc hб»Ү thб»‘ng chГәng ta Д‘бә·t chГәng vГ dб»Ҝ liб»Үu chГәng ta Д‘б»ғ chГәng chбәЎy Д‘Гҙi khi lбәЎi tбәӯp trung. VГ tГҙi nghД© Д‘Гі lГ mб»ҷt mГҙ hГ¬nh rбәҘt Д‘ГЎng sб»Ј nбәҝu chб»ү cГі cГЎc hб»Ү thб»‘ng tбәӯp trung. DГ№ bбәЎn cГі tiбәҝt kiб»Үm vГ Д‘бәЎt Д‘Ж°б»Јc bao nhiГӘu Д‘Гі tб»« quyб»Ғn lб»ұc dб»Ҝ liб»Үu của cГЎc hб»Ү thб»‘ng tбәӯp trung, tГҙi nghД© Д‘Гі cГі thб»ғ lГ mб»ҷt rủi ro rбәҘt quan trб»Қng.

Adel Nehme: ДҗГәng, tГҙi hoГ n toГ n Д‘б»“ng ГҪ vб»ӣi quan Д‘iб»ғm nГ y. DЖ°б»қng nhЖ° cГі mб»ҷt sб»ұ cГўn bбәұng tinh tбәҝ mГ , nhЖ° mб»ҷt loГ i ngЖ°б»қi, chГәng ta cбә§n tбәЎo ra giб»Ҝa viб»Үc xГўy dб»ұng mб»ҷt quбәЈn trб»Ӣ vб»Ҝng chбәҜc vГ viб»Үc tбәЎo ra mб»ҷt quбәЈn trб»Ӣ chб»‘ng lбәЎi sб»ұ suy yбәҝu, Д‘б»“ng thб»қi khГЎu mбәЎnh Д‘б»‘i vб»ӣi bбәҘt kб»і sб»ұ cб»‘ nГ o trong cГЎc nГәt, nhЖ° bбәЎn Д‘ГЈ nГіi. VГ tГҙi nghД© nhб»Ҝng gГ¬ bбәЎn Д‘б»Ғ cбәӯp б»ҹ Д‘Гўy thбәӯt sб»ұ liГӘn quan chбә·t chбәҪ Д‘бәҝn gГіc nhГ¬n vб»Ғ rủi ro liГӘn tiбәҝp, bб»ҹi bбәЎn Д‘бә·t vбәҘn Д‘б»Ғ trГӯ tuб»Ү nhГўn tбәЎo hoбә·c rủi ro tб»« trГӯ tuб»Ү nhГўn tбәЎo trong bб»‘i cбәЈnh cГЎc rủi ro khГЎc.

VГӯ dб»Ҙ, bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp vб»Ғ cГЎch tiбәҝn hГіa vГ mГЎy tГӯnh lЖ°б»Јng tб»ӯ cГі thб»ғ gia tДғng. Rủi ro tб»ұ do nбәҝu khГҙng Д‘Ж°б»Јc quбәЈn lГҪ Д‘Гәng cГЎch, nhЖ°ng bбәЎn cЕ©ng Д‘ГЈ Д‘б»Ғ cбәӯp,В

- VГӯ dб»Ҙ, vб»Ғ cГЎch sб»ұ phб»Ҙ thuб»ҷc ngГ y cГ ng tДғng lГӘn vГ o hбәЎ tбә§ng kб»№ thuбәӯt sб»‘ vГ thб»ұc tбәҝ бәЈo,В

- VГӯ dб»Ҙ, do sб»ұ suy giбәЈm của tб»ұ nhiГӘn, Д‘Гі lГ rủi ro vб»Ғ khГӯ hбәӯu б»ҹ Д‘Гўy, hoбә·c cГЎch cбәЎnh tranh Д‘б»Ӣa chГӯnh trб»Ӣ giб»Ҝa cГЎc quб»‘c gia cГі thб»ғ thГәc Д‘бә©y sб»ұ phб»Ҙ thuб»ҷc cao hЖЎn, sб»ӯ dб»Ҙng nhiб»Ғu hЖЎn cЕ©ng tбәЎo ra khбәЈ nДғng lб»ӣn hЖЎn vб»Ғ viб»Үc lбәЎm dб»Ҙng hoбә·c sб»ӯ dб»Ҙng cГі hбәЎi của trГӯ tuб»Ү nhГўn tбәЎo.

HГЈy chб»ү dбә«n chГәng tГҙi qua cГЎch chГәng ta nГӘn suy nghД© vб»Ғ sб»ұ tЖ°ЖЎng tГЎc giб»Ҝa nhб»Ҝng rủi ro nГ y, nhб»Ҝng xu hЖ°б»ӣng nГ y mб»ҷt cГЎch sГўu sбәҜc hЖЎn khi nghД© vб»Ғ rủi ro của trГӯ tuб»Ү nhГўn tбәЎo.

NativeX – Hб»Қc tiбәҝng Anh online toГ n diб»Үn “4 kб»№ nДғng ngГҙn ngб»Ҝ” cho ngЖ°б»қi Д‘i lГ m.

Vб»ӣi mГҙ hГ¬nh “Lб»ӣp Hб»Қc NГ©n” Д‘б»ҷc quyб»Ғn:

- TДғng hЖЎn 20 lбә§n chбәЎm “Д‘iб»ғm kiбәҝn thб»©c”, giГәp hiб»ғu sГўu vГ nhб»ӣ lГўu hЖЎn gбәҘp 5 lбә§n.

- TДғng khбәЈ nДғng tiбәҝp thu vГ tбәӯp trung qua cГЎc bГ i hб»Қc cГҙ Д‘б»Қng 3 – 5 phГәt.

- RГәt ngбәҜn gбә§n 400 giб»қ hб»Қc lГҪ thuyбәҝt, tДғng hЖЎn 200 giб»қ thб»ұc hГ nh.

- HЖЎn 10.000 hoбәЎt Д‘б»ҷng cбәЈi thiб»Үn 4 kб»№ nДғng ngoбәЎi ngб»Ҝ theo giГЎo trГ¬nh chuбә©n Quб»‘c tбәҝ tб»« National Geographic Learning vГ Macmillan Education.

Trond Arne Undheim: Дҗiб»Ғu Д‘бә§u tiГӘn lГ chб»ү vГ¬ cГі mб»ҷt sб»ұ tЖ°ЖЎng tГЎc khГҙng cГі nghД©a lГ tЖ°ЖЎng tГЎc Д‘Гі nhбәҘt thiбәҝt lГ tiГӘu cб»ұc, phбәЈi khГҙng? VГ¬ vбәӯy, tГЎc Д‘б»ҷng liГӘn quan cГі thб»ғ tГӯch cб»ұc vГ tiГӘu cб»ұc. BбәЎn cГі thб»ғ nghД© vб»Ғ nГі nhЖ° lГ nhб»Ҝng vГІng xoбәҜn, nhЖ°ng chГәng cЕ©ng cГі thб»ғ xoбәҜn theo hЖ°б»ӣng tГӯch cб»ұc. VГ¬ vбәӯy, chГәng ta, tбәҘt nhiГӘn, cбә§n sб»ӯ dб»Ҙng sб»ұ nhбәӯn thб»©c vб»Ғ cГЎch cГЎc yбәҝu tб»‘ tЖ°ЖЎng tГЎc vГ hoбәЎt Д‘б»ҷng theo cГЎch hб»Ү thб»‘ng Д‘б»ғ cГі lб»Јi Гӯch cho mГ¬nh.

VГ miб»…n lГ chГәng ta sб»ӯ dб»Ҙng chГәng nhЖ° lГ nhб»Ҝng chuб»—i tГӯch cб»ұc, Д‘Гәng khГҙng, Д‘Гўy lГ Д‘iб»Ғu mГ cГЎc nhГ nghiГӘn cб»©u Д‘б»•i mб»ӣi vГ nhб»Ҝng ngЖ°б»қi kiбәҝm tiб»Ғn trГӘn thб»Ӣ trЖ°б»қng chб»©ng khoГЎn vГ bбәҘt cб»© Д‘iб»Ғu gГ¬ khГЎc, khi bбәЎn sб»ӯ dб»Ҙng hiб»Үu б»©ng mбәЎng. Дҗiб»Ғu nГ y thЖ°б»қng lГ tuyб»Үt vб»қi cho tбәҘt cбәЈ mб»Қi ngЖ°б»қi liГӘn quan vГ¬ bбәЎn Д‘ang phГўn phб»‘i lб»Јi Гӯch mб»ҷt cГЎch rбәҘt, rбәҘt hiб»Үu quбәЈ.

VГ¬ vбәӯy, tГҙi nghД© chГәng ta cбә§n phбәЈi thiбәҝt kбәҝ cГЎc hб»Ү thб»‘ng cГі khбәЈ nДғng thб»ұc hiб»Үn Д‘iб»Ғu Д‘Гі vГ tiбәҝp tб»Ҙc Д‘б»•i mб»ӣi cГЎc sбәЈn phбә©m cho phГ©p chГәng ta lГ m nhб»Ҝng Д‘iб»Ғu nГ y qua cГЎc mбәЎng, nhЖ°ng Д‘б»“ng thб»қi, hГЈy rбәҘt cбә©n trб»Қng vГ¬ vГ¬ cГЎc mбәЎng nГ y rбәҘt hiб»Үu quбәЈ nбәҝu chГәng ta khГҙng hiб»ғu Д‘бә§y đủ cГЎch chГәng hoбәЎt Д‘б»ҷng, hoбә·c nбәҝu cГі ai Д‘Гі hiб»ғu rГө quГЎ vГ bбәҜt Д‘бә§u tбәӯn dб»Ҙng mГ khГҙng nГіi vб»ӣi bбәҘt kб»і ai khГЎc, Д‘Гўy thб»ұc sб»ұ lГ nhб»Ҝng Д‘iб»Ғu lб»ӣn lбәҜm Д‘б»ғ chГә ГҪ.

VГ¬ vбәӯy, tГҙi nghД© chГәng ta cбә§n tбәЎo ra nhiб»Ғu hЖЎn nhб»Ҝng ngЖ°б»қi canh gГЎc. Mб»ҷt cГЎch khГҙng chГӯnh thб»©c vГ chГәng ta cбә§n sб»ӯ dб»Ҙng cбәЈm biбәҝn vГ cГЎc nguyГӘn tбәҜc mб»ҹ Д‘б»ғ xГўy dб»ұng nhб»Ҝng hб»Ү thб»‘ng Д‘Гі. ChГәng khГҙng Д‘ЖЎn giбәЈn nhЖ° viб»Үc chб»ү lГ m nГі ngoбәЎi giao cho mб»ҷt bГӘn thб»© ba nГ o Д‘Гі giб»‘ng nhЖ° mб»ҷt ngЖ°б»қi canh gГЎc. ДҗГўy lГ nhб»Ҝng Д‘iб»Ғu chГәng ta cбә§n tГӯch hб»Јp vГ o quГЎ trГ¬nh Д‘б»•i mб»ӣi.

TГҙi thб»ұc sб»ұ mong muб»‘n tГЎi khГЎi niб»Үm hГіa nhб»Ҝng gГ¬ chГәng ta coi lГ sб»ұ Д‘б»•i mб»ӣi.VГ tГҙi nghД© chГәng ta cбә§n trб»ҹ nГӘn cГі trГЎch nhiб»Үm hЖЎn Д‘б»‘i vб»ӣi viб»Үc sб»ӯ dб»Ҙng cuб»‘i cГ№ng vГ cГЎc trЖ°б»қng hб»Јp sб»ӯ dб»Ҙng cuб»‘i cГ№ng tiб»Ғm nДғng của cГҙng nghб»Ү của mГ¬nh.В

VГ¬ vбәӯy, bбәЎn khГҙng chб»ү hoГ n thГ nh phбә§n Д‘б»•i mб»ӣi khi chб»ү tбәЎo ra mб»ҷt Д‘iб»Ғu tuyб»Үt vб»қi mГ mб»Қi ngЖ°б»қi thГӯch vГ sau Д‘Гі bбәЎn cГі thб»ғ bГЎn vб»ӣi mб»ҷt giГЎ cao. BбәЎn thб»ұc sб»ұ cбә§n tГӯch hб»Јp vГ o gГіi Д‘Гі mб»ҷt phГўn tГӯch rủi ro vб»Ғ viб»Үc nГ y cГі thб»ғ Д‘Ж°б»Јc sб»ӯ dб»Ҙng nhЖ° thбәҝ nГ o, Д‘бә·c biб»Үt khi nГі trб»ҹ nГӘn phб»• biбәҝn vГ cГі sбәөn trГӘn toГ n thбәҝ giб»ӣi nhЖ° mб»ҷt sбәЈn phбә©m cГі sбәөn toГ n cбә§u.В

VГ Д‘iб»Ғu Д‘Гі hiб»Үn tбәЎi khГҙng Д‘Ж°б»Јc thб»ұc hiб»Үn mб»ҷt cГЎch cГі hб»Ү thб»‘ng, tбәҘt nhiГӘn, nбәҝu bбәЎn lГ mб»ҷt startup, Ж°u tiГӘn lГ tбәЎo ra mб»ҷt sбәЈn phбә©m hoбәЎt Д‘б»ҷng.

VГ nбәҝu bбәЎn lГ mб»ҷt tбәӯp Д‘oГ n lб»ӣn, nбәҝu bбәЎn đủ may mбәҜn Д‘б»ғ cГі sб»ұ xГўm nhбәӯp khбәҜp thбәҝ giб»ӣi. Ngay cбәЈ khi Д‘Гі, Д‘Гҙi khi sбәЈn phбә©m của bбәЎn thбәҘt bбәЎi. VГ¬ vбәӯy, khi bбәЎn cГі mб»ҷt cГЎi gГ¬ Д‘Гі cГі vбә» hoбәЎt Д‘б»ҷng vГ ngЖ°б»қi ta yГӘu thГӯch, thГ¬ tбәЎi sao bбәЎn lбәЎi gбә·p rбәҜc rб»‘i? NhЖ°ng tГҙi nghД© vб»ӣi tЖ° cГЎch lГ mб»ҷt xГЈ hб»ҷi, vб»ӣi tЖ° cГЎch lГ nhГўn loбәЎi, chГәng ta khГҙng thб»ғ chбәҘp nhбәӯn Д‘Ж°б»Јc nhб»Ҝng sai sГіt trong cГҙng nghб»Ү gГўy hбәӯu quбәЈ nhЖ° AI.

Hoбә·c cГҙng nghб»Ү lЖ°б»Јng tб»ӯ hoбә·c thбәӯm chГӯ nhiб»Ғu cГҙng nghб»Ү sinh hб»Қc tб»•ng hб»Јp mб»ӣi mГ tГҙi sбәҪ tГӯch hб»Јp vб»ӣi trГӯ tuб»Ү nhГўn tбәЎo bб»ҹi vГ¬ chГәng sб»ӯ dб»Ҙng trГӯ tuб»Ү nhГўn tбәЎo cho sб»©c mбәЎnh tГӯnh toГЎn của chГәng. NhЖ°ng tбәҘt nhiГӘn, vб»ӣi nhб»Ҝng hбәӯu quбәЈ rбәҘt thб»ұc tбәҝ, bбәЎn Д‘ang tбәЎo ra sб»ұ sб»‘ng nhГўn tбәЎo thГҙng qua cГҙng nghб»Ү mГҙ phб»Ҹng tб»ұ nhiГӘn. Дҗiб»Ғu nГ y lГ mб»ҷt vбәҘn Д‘б»Ғ rбәҘt nghiГӘm trб»Қng vГ mб»ҷt sб»‘ trong nhб»Ҝng Д‘iб»Ғu Д‘Гі, khi chГәng thб»ұc sб»ұ Д‘Ж°б»Јc phГіng ra vГ o tб»ұ nhiГӘn, bбәЎn khГҙng thб»ғ hủy bб»Ҹ nГі.

ДҗГўy khГҙng chб»ү lГ vб»Ғ AI. Дҗб»‘i vб»ӣi tГҙi, cГЎi gГіc nhГ¬n nГ y lГ chГәng ta Д‘ang sб»‘ng trong mб»ҷt xГЈ hб»ҷi nЖЎi chГәng ta, cГі lбәҪ lбә§n Д‘бә§u tiГӘn, bбәЎn biбәҝt Д‘бәҘy, trong nhб»Ҝng 30, 40 nДғm qua, chГәng ta Д‘ang cГі mб»ҷt quyб»Ғn lб»ұc mб»ӣi Д‘б»‘i vб»ӣi sб»ұ sб»‘ng nhЖ° vбәӯy. VГ chГәng ta phбәЈi sб»ӯ dб»Ҙng nГі mб»ҷt cГЎch cГі trГЎch nhiб»Үm vГ¬ chГәng ta sбәҪ khГҙng cГі cЖЎ hб»ҷi thб»© hai, tб»ұ nhiГӘn cГі thб»ғ tб»“n tбәЎi trong vГІng 100,000 nДғm tб»ӣi, nhЖ°ng Д‘iб»Ғu Д‘Гі khГҙng quan trб»Қng cho con ngЖ°б»қi hiб»Үn tбәЎi, phбәЈi khГҙng?

VГ¬ vбәӯy, liб»Үu thiГӘn nhiГӘn cГі tб»“n tбәЎi trong 100.000 nДғm tб»ӣi vГ tГЎi tбәЎo Д‘a dбәЎng sinh hб»Қc hay khГҙng, nбәҝu chГәng ta tб»ұ hủy hoбәЎi nГі trong vГІng 2000 nДғm tб»ӣi. TГҙi tin rбәұng chГәng ta Д‘ang gбә·p rбәҜc rб»‘i sГўu sбәҜc. ДҗГўy chбәҜc chбәҜn khГҙng phбәЈi lГ mб»ҷt lб»ұa chб»Қn mГ chГәng tГҙi muб»‘n xem xГ©t.

Adel Nehme: Дҗiб»Ғu nГ y chбәҜc chбәҜn khГҙng phбәЈi lГ mб»ҷt lб»ұa chб»Қn mГ chГәng ta muб»‘n xem xГ©t, vГ bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp Д‘бәҝn cГЎch chГәng ta cбә§n phбәЈi Д‘б»Ӣnh lбәЎi cГЎi gб»Қi lГ Д‘б»•i mб»ӣi trong mб»ҷt thб»қi Д‘бәЎi mГ cГі thб»ғ cГі nhб»Ҝng rủi ro quan trб»Қng Д‘б»‘i vб»ӣi sб»ұ Д‘б»•i mб»ӣi khГҙng kiб»ғm soГЎt. Vбәӯy thГ¬ hГЈy hЖ°б»ӣng dбә«n chГәng tГҙi qua cГЎch bбәЎn muб»‘n Д‘б»Ӣnh nghД©a Д‘Гі phГЎt triб»ғn theo thб»қi gian vГ bбәЎn nghД© sao vб»Ғ Д‘iб»Ғu Д‘Гі?В

CГі thб»ғ cГі nhб»Ҝng ngЖ°б»қi chЖЎi trong ngГ nh cГҙng nghiб»Үp trГӯ thГҙng minh nhГўn tбәЎo, nбәҝu cГі, mГҙ hГ¬nh Гӯt nhбәҘt lГ Д‘б»Ӣnh nghД©a vб»Ғ Д‘б»•i mб»ӣi khi hб»Қ triб»ғn khai cГЎc sбәЈn phбә©m vГ dб»Ӣch vб»Ҙ trГӯ tuб»Ү nhГўn tбәЎo.

Trond Arne Undheim: Дҗiб»Ғu Д‘бә§u tiГӘn tГҙi muб»‘n nГіi, vГ tГҙi cГі mб»ҷt cuб»‘n sГЎch mб»ӣi cГі tГӘn lГ Ecotech, trong Д‘Гі tГҙi khГЎm phГЎ mб»ҷt chГәt vб»Ғ cuб»ҷc tranh luбәӯn liб»Үu mб»Қi thб»© hiб»Үn nay cГі nГӘn trб»ҹ thГ nh quy mГҙ khб»•ng lб»“ vГ nб»Ғn tбәЈng khб»•ng lб»“ hay khГҙng, hay liб»Үu Д‘б»•i mб»ӣi hiб»Үn nay cбә§n thu nhб»Ҹ lбәЎi vб»ӣi nhб»Ҝng hiб»Үu б»©ng phГўn phб»‘i nhб»Ҹ hЖЎn. VГ chГәng ta thб»ұc sб»ұ Д‘ang cбә§n mб»ҷt tЖ° duy suy giбәЈm hoГ n toГ n, cГі nghД©a lГ quy mГҙ nhб»Ҹ hЖЎn, cГі thб»ғ Гӯt tДғng trЖ°б»ҹng hЖЎn.

VГ tГҙi nghД© cГЎi phГўn chia hai chiб»Ғu nГ y mб»ҷt cГЎch nГ o Д‘Гі lГ sai lбә§m vГ¬ khГҙng phбәЈi lГ Д‘б»•i mб»ӣi phбәЈi trб»ҹ nГӘn Гӯt hiб»Үu quбәЈ hoбә·c quy mГҙ nhб»Ҹ chГӯnh nГі. Chб»ү lГ cбә§n thay Д‘б»•i mб»Ҙc tiГӘu cб»‘t lГөi của nГі. Mб»Ҙc tiГӘu khГҙng chб»ү lГ tбәЎo ra cГЎc lД©nh vб»ұc kinh tбәҝ cho cГЎc nhГіm xГЈ hб»ҷi nhб»Ҹ, cho dГ№ Д‘Гі lГ cГЎc startup, cГЎ nhГўn giГ u cГі hoбә·c cГЎc mбәЎng lЖ°б»ӣi doanh nghiб»Үp.

ChГәng ta cбә§n phбәЈi nghД© toГ n cбәЈnh rб»ҷng lб»ӣn hЖЎn. Дҗiб»Ғu Д‘Гі khГҙng cГі nghД©a lГ Д‘б»•i mб»ӣi khГҙng nГӘn xбәЈy ra. VГ¬ vбәӯy, theo cГЎch tГҙi nghД© vб»Ғ Д‘б»•i mб»ӣi, tГҙi nghД© tб»« “suy giбәЈm” lГ mб»ҷt tб»« cГі ГҪ nghД©a hб»Ҝu Гӯch. TГҙi khГҙng biбәҝt liб»Үu bбәЎn cГі liГӘn quan Д‘бәҝn khГЎi niб»Үm Д‘Гі hay khГҙng, ГҪ tЖ°б»ҹng nГ y Д‘ГЈ xuбәҘt hiб»Үn trong vГ i nДғm qua trong kinh tбәҝ mГҙi trЖ°б»қng.

Trong Д‘Гі, hб»Қ nghД© rбәұng khГҙng chб»ү quГЎ trГ¬nh Д‘б»•i mб»ӣi cбә§n thay Д‘б»•i, mГ logic toГ n bб»ҷ cГЎch chГәng ta Д‘б»•i mб»ӣi cЕ©ng cбә§n phбәЈi thay Д‘б»•i. Hiб»Үn nay, trong cб»ҷng Д‘б»“ng cГі sб»ұ bбәҘt Д‘б»“ng. Mб»ҷt sб»‘ ngЖ°б»қi cho rбәұng chГәng ta cбә§n tiГӘu thб»Ҙ Гӯt hЖЎn, Д‘i lбәЎi Гӯt hЖЎn, vГ lГ m Гӯt hЖЎn, nГіi chung, Гӯt hЖЎn mб»Қi thб»©. Trong cuб»‘n sГЎch của mГ¬nh, tГҙi Д‘ГЈ xem xГ©t lбәӯp luбәӯn Д‘Гі vГ kбәҝt luбәӯn rбәұng nГі chбәҜc chбәҜn sбәҪ thбәҘt bбәЎi.

Дҗiб»Ғu nГ y khГҙng phбәЈi lГ cГЎch chГәng ta hoбәЎt Д‘б»ҷng nhЖ° con ngЖ°б»қi. ChбәҜc chбәҜn lГ khГҙng phбәЈi con ngЖ°б»қi mбәЎnh mбәҪ, sГЎng tбәЎo muб»‘n cГЎi gГіc nhГ¬n Д‘Гі. VГ¬ vбәӯy, cГЎi gГіc nhГ¬n Д‘Гі sбәҪ khГҙng thб»ғ thГ nh cГҙng. TГҙi muб»‘n mб»ҷt mГҙ hГ¬nh Д‘б»•i mб»ӣi mб»ҹ rб»ҷng, mб»ҷt mГҙ hГ¬nh Д‘б»•i mб»ӣi lбәЎc quan, nhЖ°ng mб»ҷt nЖЎi mГ bбәЎn luГҙn nghД© vб»Ғ trЖ°б»қng hб»Јp sб»ӯ dб»Ҙng cuб»‘i cГ№ng vГ nЖЎi bбәЎn sбәөn sГ ng bбәЈo vб»Ү nГі, gбә§n giб»‘ng nhЖ° cГўu nГіi của tГІa ГЎn, ngay cбәЈ khi kбә» xбәҘu cГі quyб»Ғn truy cбәӯp vГ o cГҙng nghб»Ү, Д‘Гўy lГ cГЎch chГәng tГҙi sбәҪ tiбәҝn hГ nh.

Adel Nehme: VГ tГҙi nghД© Д‘iб»Ғu nГ y kбәҝt nб»‘i rбәҘt tб»‘t vб»ӣi cГўu hб»Ҹi tiбәҝp theo của tГҙi vб»Ғ tГ¬nh trбәЎng của trГӯ thГҙng minh nhГўn tбәЎo mГЈ nguб»“n mб»ҹ vГ nhб»Ҝng hбәӯu quбәЈ tiб»Ғm бә©n mГ chГәng ta thбәҘy trong tЖ°ЖЎng lai sбәҜp tб»ӣi hoбә·c trong tЖ°ЖЎng lai ngбәҜn hбәЎn. TГҙi nghД© rбәұng, Д‘бә·c biб»Үt lГ khi bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp trЖ°б»ӣc Д‘Гі trong cuб»ҷc trГІ chuyб»Үn của chГәng ta rбәұng cГі lбәҪ lГ thб»қi Д‘iб»ғm khГҙng Д‘Гәng Д‘б»ғ lГ m lбәЎi chuГҙng bГЎo Д‘б»ҷng vб»Ғ rủi ro tб»“n tбәЎi vб»ӣi viб»Үc phГЎt hГ nh cГЎc mГҙ hГ¬nh của Chachapitian vГ cГЎc mГҙ hГ¬nh ngГҙn ngб»Ҝ lб»ӣn.

VГ tГҙi hoГ n toГ n Д‘б»“ng ГҪ vб»ӣi Д‘iб»ғm Д‘Гі. VГ nhiб»Ғu ngЖ°б»қi trong ngГ nh cГҙng nghiб»Үp, chГәng ta thбәҘy sб»ұ phГўn chia Д‘Гі ngГ y nay giб»Ҝa nhб»Ҝng ngЖ°б»қi muб»‘n sб»ӯ dб»Ҙng mГҙ hГ¬nh nguб»“n Д‘Гіng vГ cГЎc mГҙ hГ¬nh cЖЎ sб»ҹ Д‘Ж°б»Јc tбәӯp trung trong mб»ҷt sб»‘ bГӘn thГ¬ trб»ҹ nГӘn vб»Ғ cЖЎ bбәЈn lГ nhб»Ҝng mГҙ hГ¬nh ngГҙn ngб»Ҝ lб»ӣn duy nhбәҘt cГі sбәөn mГ bбәЎn cГі thб»ғ thбәҘy ngГ y nay.

CГі nhб»Ҝng ngЖ°б»қi khГЎc nhЖ°: Andrew Ng, Yann LeCun Д‘ang thбәЈo luбәӯn vб»Ғ sб»ұ cбә§n thiбәҝt của viб»Үc tДғng tб»‘c trГӯ tuб»Ү nhГўn tбәЎo mГЈ nguб»“n mб»ҹ vГ sб»ұ phГЎt triб»ғn của trГӯ tuб»Ү nhГўn tбәЎo. CГі lбәҪ bбәЎn nghД© thбәҝ nГ o vб»Ғ cuб»ҷc tranh luбәӯn nГ y, Д‘бә·c biб»Үt lГ trong tЖ°ЖЎng lai vГ nhб»Ҝng rủi ro Д‘i kГЁm vб»ӣi nГі. VГ tГҙi rбәҘt muб»‘n biбәҝt quan Д‘iб»ғm của bбәЎn vб»Ғ sб»ұ Д‘ГЎnh Д‘б»•i giб»Ҝa trГӯ thГҙng minh nhГўn tбәЎo mГЈ nguб»“n mб»ҹ vГ trГӯ thГҙng minh nhГўn tбәЎo nguб»“n Д‘Гіng tб»« gГіc Д‘б»ҷ rủi ro.

Trond Arne Undheim: ГҖ, cГі nhб»Ҝng rủi ro vГ sau Д‘Гі lГ cГЎc nghб»Ӣ Д‘б»Ӣnh. VГ , tГҙi Д‘ГЈ lГ m viб»Үc trong lД©nh vб»ұc cГҙng nghб»Ү lб»ӣn vГ thбәӯm chГӯ, tГҙi cГі thб»ғ nГіi lГ Д‘ГЈ lГ m Д‘бәЎi lГҪ quбәЈng cГЎo mб»ҷt phбә§n của cuб»ҷc Д‘б»қi tГҙi. VГ¬ vбәӯy, tГҙi hiб»ғu Д‘Ж°б»Јc cбәЈm giГЎc muб»‘n Д‘бә·t quan Д‘iб»ғm của bбәЎn dЖ°б»ӣi dбәЎng “TГҙi Д‘ang cб»‘ gбәҜng cб»©u rб»—i nhГўn loбәЎi”. ДҗГі lГ mб»ҷt sб»©c hбәҘp dбә«n rбәҘt lб»ӣn Д‘б»‘i vб»ӣi lбәӯp luбәӯn Д‘Гі, cho dГ№ bбәЎn б»ҹ bГӘn trong, bбәЎn biбәҝt Д‘бәҘy, tГҙi cЕ©ng Д‘ang lГ m viб»Үc vб»ӣi tЖ° cГЎch lГ ngЖ°б»қi quбәЈn lГҪ.

CГі vбә» nhЖ° mб»Қi ngЖ°б»қi Д‘бәҝn vб»ӣi bбәЎn tб»« khu vб»ұc tЖ° nhГўn vб»ӣi vбә» nhЖ° muб»‘n cб»©u thбәҝ giб»ӣi. Дҗiб»Ғu nГ y rбәҘt thuyбәҝt phб»Ҙc. VГ б»ҹ phГӯa khГЎc, cho dГ№ bбәЎn ủng hб»ҷ phong cГЎch mГЈ nguб»“n mб»ҹ hay bбәЎn Д‘ang bГЎn mб»ҷt sбәЈn phбә©m nguб»“n Д‘Гіng nГ o Д‘Гі, nбәҝu bбәЎn chб»Қn con Д‘Ж°б»қng cao cбәЈ bбәЈo rбәұng “TГҙi nghД© vб»Ғ tбәҘt cбәЈ mб»Қi ngЖ°б»қi khГЎc”, ban Д‘бә§u mб»Қi ngЖ°б»қi sбәҪ lбәҜng nghe, nhЖ°ng sau Д‘Гі chб»©ng minh sбәҪ nГіi lГӘn mб»Қi thб»©.

BбәЎn Д‘ГЈ nghД© Д‘бәҝn bбәҘt kб»і ai khГЎc vГ mб»Қi ngЖ°б»қi khГЎc khГҙng? VГ cГі thб»ғ bбәЎn Д‘ГЈ Д‘Гәng. VГ cГі thб»ғ nhб»Ҝng ngЖ°б»қi nГ y chб»ү Д‘ang chб»Қn thб»қi Д‘iб»ғm nГ y. NhЖ°ng Д‘iб»Ғu tГҙi muб»‘n nГіi lГ , bбәЎn khГҙng thб»ғ la hГ©t vГ kГӘu gГ o nhiб»Ғu lбә§n. ГҚt nhбәҘt lГ mб»ҷt ngЖ°б»қi Д‘ГЈ kГӘu gГ o rб»“i, bГўy giб»қ bбәЎn Д‘ГЈ sб»ӯ dб»Ҙng quyб»Ғn của mГ¬nh. VГ¬ vбәӯy, tГҙi nghД© rбәұng thб»қi Д‘iб»ғm Д‘Гі thбәӯt thГә vб»Ӣ.

VГ tГҙi nghД© rбәұng cГі nhб»Ҝng kбәҝ hoбәЎch бә©n sau Д‘Гі. Hб»Қ muб»‘n kiб»ғm soГЎt quy trГ¬nh quy Д‘б»Ӣnh. Hб»Қ muб»‘n quy Д‘б»Ӣnh. BГўy giб»қ, chб»© khГҙng phбәЈi trong 10 nДғm tб»ӣi, bб»ҹi vГ¬ sбәЈn phбә©m của hб»Қ Д‘ang xuбәҘt hiб»Үn ngay bГўy giб»қ. TГҙi lГ ngЖ°б»қi tin tЖ°б»ҹng lб»ӣn vГ o sб»ұ mб»ҹ cб»ӯa trong cГҙng nghб»Ү. VГ¬ vбәӯy, nhб»Ҝng ngЖ°б»қi Д‘ГЈ theo dГөi cГҙng viб»Үc của tГҙi biбәҝt rбәұng tГҙi Д‘ГЈ lГ m viб»Үc Д‘б»ғ khuyбәҝn khГӯch cГҙng nghб»Ү mГЈ nguб»“n mб»ҹ vГ nhбәҘt Д‘б»Ӣnh lГ cГҙng nghб»Ү tЖ°ЖЎng thГӯch trong suб»‘t 20 nДғm qua.

CбәЈ trong vГ ngoГ i chГӯnh phủ, cЕ©ng nhЖ° trong cГЎc cГҙng ty tЖ° nhГўn vГ ngЖ°б»қi khб»ҹi nghiб»Үp. VГ¬ vбәӯy, tбәҘt cбәЈ, tбәҘt cбәЈ, tбәҘt cбәЈ trГӘn Д‘б»Ғu khГҙng cГі nghД©a lГ tГҙi nghД© rбәұng chб»ү cГҙng nghб»Ү mГЈ nguб»“n mб»ҹ mб»ӣi lГ giбәЈi phГЎp. TГҙi nghД© cГі mб»ҷt sб»ұ Д‘ГЎnh Д‘б»•i б»ҹ Д‘Гўy vГ nhб»Ҝng mГҙ hГ¬nh liГӘn bang hГіa nЖЎi bбәЎn chia sбә» mб»ҷt lЖ°б»Јng thГӯch hб»Јp mГ khГҙng tiбәҝt lб»ҷ danh tГӯnh cЖЎ bбәЈn của dб»Ҝ liб»Үu, Д‘Гі cЕ©ng lГ mб»ҷt giГЎ trб»Ӣ.

BГўy giб»қ, tГҙi lo lбәҜng vб»Ғ viб»Үc cГЎc bб»ҷ dб»Ҝ liб»Үu lб»ӣn bб»Ӣ mбәҘt hoбә·c trб»ҹ nГӘn Д‘б»ҷc quyб»Ғn của cГЎc nhГ cung cбәҘp. ДҗГәng, tбәҘt nhiГӘn, Д‘Гі lГ mб»ҷt vбәҘn Д‘б»Ғ khб»•ng lб»“. TГҙi cбәЈm thбәҘy nhЖ° mб»—i thбәӯp kб»· chГәng ta lo lбәҜng vб»Ғ mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі. Thбәӯp kб»· trЖ°б»ӣc, chГәng ta lo lбәҜng vб»Ғ dб»Ҝ liб»Үu lб»ӣn vГ ai sб»ҹ hб»Ҝu tбәҘt cбәЈ dб»Ҝ liб»Үu nГ y. NhЖ°ng sau Д‘Гі, bГўy giб»қ tГҙi nghД© rбәұng chГәng ta Д‘ang sб»‘ng trong thбәӯp kб»· của cГЎc thuбәӯt toГЎn.

Ai cГі thuбәӯt toГЎn Д‘Гәng? BбәЎn cГі thuбәӯt toГЎn, quan trб»Қng gГ¬ vб»Ғ dб»Ҝ liб»Үu? BбәЎn thбәӯm chГӯ cГі thб»ғ cГі dб»Ҝ liб»Үu kГ©m chбәҘt lЖ°б»Јng vГ¬ bбәЎn cГі thuбәӯt toГЎn tб»‘t nhбәҘt. VГ¬ vбәӯy, bбәЎn sбәҪ chiбәҝn thбәҜng. VГ sau Д‘Гі, chГәng ta bГўy giб»қ cЕ©ng Д‘ang nhбәӯn ra rбәұng cЖЎ sб»ҹ hбәЎ tбә§ng của chГәng ta rбәҘt tб»“i tб»Ү. ChГәng ta Д‘ang xГўy dб»ұng tбәҘt cбәЈ mб»Қi thб»© trГӘn nб»Ғn tбәЈng nГ y.

ChГәng ta muб»‘n cГҙng nghб»Ү lЖ°б»Јng tб»ӯ vГ¬ chГәng ta muб»‘n mб»ҷt kiбәҝn trГәc mб»ӣi, khГҙng phбәЈi dб»ұa trГӘn silic, Д‘б»ғ xГўy dб»ұng hб»Ү thб»‘ng của mГ¬nh, dГ№ NVIDIA Д‘ГЈ cho ra Д‘б»қi nhб»Ҝng vi mбәЎch tб»‘t hЖЎn. Cuб»‘i cГ№ng, chГәng ta sбәҪ cбә§n nГўng cбәҘp Д‘б»ғ cГі Д‘Ж°б»Јc hiб»Үu suбәҘt gбәҘp nghГ¬n lбә§n vГ chГәng ta cбә§n cГЎc cГҙng nghб»Ү khГЎc. VГ¬ vбәӯy, sб»ұ mГӘ hoбә·c vб»ӣi tб»«ng phбә§n riГӘng lбә» của AI hay nб»Ғn tбәЈng sб»‘ luГҙn lГ mб»ҷt cГЎch tiбәҝp cбәӯn sai lбә§m.

VГ¬ vбәӯy, tГҙi nghД©, tГҙi luГҙn quan tГўm Д‘бәҝn sб»ұ minh bбәЎch trong dб»Ҝ liб»Үu. NhЖ°ng tГҙi cho rбәұng sб»ұ minh bбәЎch trong thuбәӯt toГЎn vГ sб»ұ minh bбәЎch trГӘn mб»Қi lД©nh vб»ұc Д‘б»Ғu quan trб»Қng. VГ thб»ұc tбәҝ, Д‘Гі lГ cГЎch chГәng ta Д‘ГЈ tбәЎo ra hб»Ү thб»‘ng phГЎp luбәӯt của mГ¬nh, phбәЈi khГҙng? Дҗб»ғ bбәЈo vб»Ү quyб»Ғn sб»ҹ hб»Ҝu trГӯ tuб»Ү. ChГәng ta nГіi rбәұng cГЎc bбәұng sГЎng chбәҝ vГ nhб»Ҝng thб»© tЖ°ЖЎng tб»ұ, chГәng Д‘б»Ғu cбә§n phбәЈi mб»ҹ cб»ӯa.В

Mб»Қi ngЖ°б»қi Д‘б»Ғu cбә§n hiб»ғu. Дҗiб»Ғu nГ y khГҙng cГі nghД©a lГ , bбәЎn biбәҝt, Д‘б»‘i vб»ӣi cГЎc bбәұng sГЎng chбәҝ, khi chГәng cГі giГЎ trб»Ӣ, Д‘Гі lГ mб»ҷt thб»қi kб»і rбәҘt lГўu trЖ°б»ӣc, chủ yбәҝu б»ҹ khГҙng gian khГҙng sб»‘, chГәng cГі Гӯch vГ¬ mб»Қi ngЖ°б»қi cГі thб»ғ nhГ¬n thбәҘy Д‘iб»Ғu gГ¬ Д‘ang diб»…n ra.

DД© nhiГӘn, hб»Қ vбә«n phбәЈi trбәЈ tiб»Ғn cho chủ bбәұng sГЎng chбәҝ Д‘Гі. BГўy giб»қ, trong lД©nh vб»ұc kб»№ thuбәӯt sб»‘, mб»Қi thб»© diб»…n ra mб»ҷt cГЎch khГЎc biб»Үt. Bбәұng sГЎng chбәҝ khГҙng cГІn quГЎ hб»Ҝu Гӯch nб»Ҝa. NhЖ°ng Д‘iб»Ғu Д‘Гі khГҙng cГі nghД©a lГ bбәЎn khГҙng thб»ғ tuyГӘn bб»‘ quyб»Ғn sб»ҹ hб»Ҝu vГ hЖ°б»ҹng lб»Јi tб»« viб»Үc phГЎt triб»ғn cГҙng nghб»Ү. VГ¬ vбәӯy, tГҙi nghД© chГәng ta cбә§n phбәЈi suy nghД© lбәЎi cГЎch mб»Қi thб»© hoбәЎt Д‘б»ҷng.

ChГәng ta khГҙng thб»ғ lГ m mб»Қi thб»© theo mб»ҷt cГЎch trong suб»‘t 30 nДғm. ChГәng ta phбәЈi linh hoбәЎt. ChГәng ta phбәЈi cho phГ©p cГЎc mГҙ hГ¬nh cбәҘp phГ©p khГЎc nhau cho cГҙng nghб»Ү. ChГәng ta cЕ©ng phбәЈi nhбәӯn thб»©c rбәұng nбәҝu chГәng ta ГЎp dб»Ҙng mГҙ hГ¬nh cбәҘp phГ©p “lan truyб»Ғn” trГӘn toГ n cбә§u, Д‘iб»Ғu nГ y cГі thб»ғ бәЈnh hЖ°б»ҹng Д‘бәҝn mб»‘i quan hб»Ү giб»Ҝa cГЎc cГҙng nghб»Ү mГ chГәng ta cГі thб»ғ chЖ°a sбәөn sГ ng thб»ұc hiб»Үn.

Vбәӯy nГі khГҙng Д‘ЖЎn giбәЈn nhЖ° viб»Үc ГЎp dб»Ҙng mб»ҷt loбәЎi giбәҘy phГ©p lan truyб»Ғn cho tбәҘt cбәЈ cГҙng nghб»Ү, phбәЈi khГҙng? Дҗiб»Ғu Д‘Гі Гӯt nhбәҘt cЕ©ng lГ Д‘iб»Ғu chГәng ta cбә§n phбәЈi chuбә©n bб»Ӣ. VГ¬ vбәӯy, tГҙi nghД© chГәng ta cбә§n thoГЎt khб»Ҹi khГҙng gian hбә№p nГ y, nЖЎi mб»Қi thб»© bГўy giб»қ phбәЈi mб»ҹ hoбә·c mб»Қi thб»© Д‘б»Ғu nГӘn Д‘Гіng vГ¬ vбәӯy nhГ sГЎng tбәЎo mб»ӣi cГі thб»ғ sГЎng tбәЎo.

CбәЈ hai Д‘б»Ғu khГҙng chГӯnh xГЎc.

Adel Nehme: Дҗiб»Ғu thГә vб»Ӣ vб»Ғ nhб»Ҝng gГ¬ bбәЎn Д‘б»Ғ cбәӯp б»ҹ Д‘Гўy lГ nguy cЖЎ tiб»Ғm бә©n của viб»Үc bб»Ӣ chiбәҝm Д‘Гіng quy Д‘б»Ӣnh mГ bбәЎn Д‘ГЈ thбәЈo luбәӯn, Д‘iб»Ғu mГ tГҙi nghД© bбәЎn Д‘ГЈ thб»ұc sб»ұ hiб»ғu rГө б»ҹ Д‘Гўy. HбәҘp dбә«n khГЎc vб»Ғ cuб»ҷc thбәЈo luбәӯn vб»Ғ mГЈ nguб»“n mб»ҹ lГ бәЈnh hЖ°б»ҹng tiб»Ғm бә©n của trГӯ tuб»Ү nhГўn tбәЎo Д‘б»‘i vб»ӣi cГЎc rủi ro lan truyб»Ғn khГЎc mГ bбәЎn Д‘ГЈ thбәЈo luбәӯn trong nghiГӘn cб»©u của mГ¬nh.В

VГ bбәЎn Д‘ГЈ Д‘б»Ғ cбәӯp б»ҹ Д‘Гўy trong cuб»ҷc trГІ chuyб»Үn trЖ°б»ӣc Д‘Гі rбәұng khГҙng phбәЈi tбәҘt cбәЈ cГЎc chuб»—i hбәӯu quбәЈ Д‘б»Ғu lГ tiГӘu cб»ұc, khГҙng phбәЈi tбәҘt cбәЈ cГЎc tЖ°ЖЎng tГЎc Д‘б»Ғu lГ tiГӘu cб»ұc, vГ theo tГҙi, theo nhiб»Ғu cГЎch, chГәng ta thбәҘy trГӯ tuб»Ү nhГўn tбәЎo Д‘ang Д‘Гіng mб»ҷt vai trГІ quan trб»Қng vГ cГі thб»ғ lГ m chбәӯm lбәЎi rủi ro tiб»Ғm бә©n của cГЎc rủi ro lб»ӣn khГЎc, phбәЈi khГҙng?В

- VГӯ dб»Ҙ, nhб»Ҝng bЖ°б»ӣc tiбәҝn trong trГӯ tuб»Ү nhГўn tбәЎo cГі thб»ғ giГәp chГәng ta mб»ҹ khГіa cГЎc vбәӯt liб»Үu mб»ӣi cГі thб»ғ hoбәЎt Д‘б»ҷng nhЖ° nguб»“n nДғng lЖ°б»Јng mб»ӣi hoбә·c kГӯch thГӯch sб»ұ cбәЈi tiбәҝn trong lД©nh vб»ұc chДғm sГіc sб»©c khб»Ҹe, rбә» hЖЎn vГ nhanh chГіng hЖЎn, Д‘Гәng khГҙng?

Nhб»Ҝng thay Д‘б»•i nГ y cГі xu hЖ°б»ӣng бәЈnh hЖ°б»ҹng Д‘бәҝn cГЎch cГЎc quб»‘c gia nghД© vб»Ғ chiбәҝn tranh, vГӯ dб»Ҙ, phбәЈi khГҙng? CГі mб»ҷt tбәӯp hб»Јp toГ n bб»ҷ cГЎc mб»‘i quan hб»Ү phб»©c tбәЎp б»ҹ Д‘Гўy cГі thб»ғ Д‘Ж°б»Јc giбәЈm nhбә№ vГ cбәЈi thiб»Үn thГҙng qua trГӯ thГҙng minh nhГўn tбәЎo (AI).В

HГЈy tбәӯn dб»Ҙng AI mб»ҷt cГЎch thГҙng minh

Vбәӯy cГі lбәҪ khi nhГ¬n vГ o cГЎc trЖ°б»қng hб»Јp sб»ӯ dб»Ҙng tiб»Ғm nДғng của trГӯ tuб»Ү nhГўn tбәЎo vГ tГЎc Д‘б»ҷng tГӯch cб»ұc trГӘn nhiб»Ғu rủi ro khГЎc nhau, cГі thб»ғ bбәЎn giбәЈi thГӯch thГӘm vб»Ғ nhб»Ҝng gГ¬ bбәЎn nhГ¬n thбәҘy lГ con Д‘Ж°б»қng tб»‘t nhбәҘt Д‘б»ғ tб»‘i Ж°u hГіa mб»ҷt tЖ°ЖЎng lai nЖЎi mГ AI Д‘Гіng mб»ҷt vai trГІ tГӯch cб»ұc trong giбәЈm nhбә№ nhб»Ҝng rủi ro tiб»Ғm бә©n cГі thб»ғ kГ©o dГ i.

Trond Arne Undheim: Дҗiб»Ғu Д‘бә§u tiГӘn tГҙi nghД© lГ nГіi Д‘ЖЎn giбәЈn rбәұng tГҙi Д‘ГЈ nghiГӘn cб»©u vб»Ғ internet suб»‘t 20, 30 nДғm, Д‘Гәng khГҙng? VГ tГҙi nghД© theo mб»ҷt cГЎch tЖ°ЖЎng tб»ұ nhЖ° cГі rбәҘt nhiб»Ғu ngЖ°б»қi lбәЎc quan nghД© rбәұng internet sбәҪ lГ m cho mб»Қi thб»© trб»ҹ nГӘn bГ¬nh Д‘бәіng, sбәҪ khГҙng cГІn ngЖ°б»қi nghГЁo, sбәҪ khГҙng cГІn ngЖ°б»қi thiбәҝu thГҙng tin nб»Ҝa, mб»Қi ngЖ°б»қi sбәҪ Д‘Ж°б»Јc giГЎo dб»Ҙc, Д‘Гәng khГҙng?

Mб»Қi thб»© sбәҪ thay Д‘б»•i. KhГҙng cГҙng nghб»Ү nГ o cГі tiб»Ғm nДғng lГ m xГЎo trб»ҷn mб»Қi thб»© trГӘn thбәҝ giб»ӣi, cho dГ№ Д‘Гі lГ vб»Ғ mбә·t vбәӯt lГҪ, tinh thбә§n, hay bбәҘt kб»і khГӯa cбәЎnh nГ o khГЎc. Do Д‘Гі, giб»‘ng nhЖ° internet Д‘ГЈ tб»“n tбәЎi vГ tДғng cЖ°б»қng cбәҘu trГәc quyб»Ғn lб»ұc hiб»Үn tбәЎi, cЕ©ng nhЖ° mang Д‘бәҝn cЖЎ hб»ҷi mб»ӣi cho ngЖ°б»қi khГЎc, Д‘iб»Ғu tЖ°ЖЎng tб»ұ cГі thб»ғ nГіi vб»Ғ trГӯ tuб»Ү nhГўn tбәЎo, dГ№ bбәЎn Д‘б»Ӣnh nghД©a nГі nhЖ° thбәҝ nГ o.

NГі sбәҪ dбә«n Д‘бәҝn nhб»Ҝng Д‘iб»Ғu tб»‘t, nhб»Ҝng Д‘iб»Ғu khГҙng quГЎ tГӯch cб»ұc, vГ rбәҘt nhiб»Ғu thб»© б»ҹ giб»Ҝa. VГ¬ vбәӯy, khi chГәng ta nghД© vб»Ғ tiб»Ғm nДғng của nГі, vГ tГҙi Д‘б»“ng ГҪ vб»ӣi bбәЎn, tiб»Ғm nДғng lб»ӣn nhбәҘt của trГӯ tuб»Ү nhГўn tбәЎo lГ Д‘б»ғ theo dГөi nhб»Ҝng rủi ro khГЎc vГ tДғng cЖ°б»қng nhб»Ҝng Д‘б»•i mб»ӣi mГ chГәng ta thб»ұc sб»ұ cбә§n Д‘б»ғ thбәҝ giб»ӣi nГ y phГЎt triб»ғn. VГ lД©nh vб»ұc y tбәҝ lГ mб»ҷt vГӯ dб»Ҙ tuyб»Үt vб»қi.

Quan trбәҜc mГҙi trЖ°б»қng lГ mб»ҷt vГӯ dб»Ҙ khГЎc vГҙ cГ№ng quan trб»Қng vГ lб»ӣn lao. ДҗГі chб»ү lГ nhб»Ҝng bЖ°б»ӣc Д‘бә§u, nhЖ°ng tГҙi khГҙng nghД© chГәng ta nГӘn giбәЈ Д‘б»Ӣnh, mong Д‘б»Јi, hoбә·c thбәӯm chГӯ hy vб»Қng rбәұng TrГӯ thГҙng minh NhГўn tбәЎo trong chГӯnh nГі lГ tГӯch cб»ұc hoбә·c tiГӘu cб»ұc. Дҗiб»Ғu nГ y lГ trГЎch nhiб»Үm của chГәng ta Д‘б»ғ Д‘бәЈm bбәЈo rбәұng nГі cЖЎ bбәЈn lГ tб»‘t nhбәҘt cГі thб»ғ.

NhЖ°ng nГі khГҙng phбәЈi lГ mб»ҷt lб»ұc lЖ°б»Јng vДғn minh tГӯch cб»ұc chб»ү sбәҪ dбә«n Д‘бәҝn nhб»Ҝng Д‘iб»Ғu tб»‘t Д‘бә№p nбәҝu ta lГ m Д‘Гәng. NГі sбәҪ dбә«n Д‘бәҝn nhб»Ҝng Д‘iб»Ғu kinh khủng dГ№ ta lГ m gГ¬. NhЖ°ng Д‘iб»Ғu Д‘Гі khГҙng cГі nghД©a lГ chГәng ta sбәҪ ngб»«ng lбәЎi. KhГҙng ai cГі quyб»Ғn lб»ұc ngб»«ng lбәЎi nГі. VГ¬ vбәӯy, hГЈy ngб»«ng thбәЈo luбәӯn vб»Ғ viб»Үc dб»«ng mб»ҷt cГҙng nghб»Ү.

Дҗiб»Ғu Д‘Гі khГҙng cГі nghД©a lГ chГәng ta khГҙng thб»ғ Д‘iб»Ғu chб»үnh, sб»ӯa Д‘б»•i, lГ m viб»Үc vб»ӣi nГі, dб»ұ Д‘oГЎn nГі, xГўy dб»ұng kб»Ӣch bбәЈn xung quanh nГі, vГ phГЎt triб»ғn linh hoбәЎt vГ chiбәҝn lЖ°б»Јc giбәЈm nhбә№ của chГӯnh chГәng ta. ДҗГі lГ nhб»Ҝng gГ¬ chГәng ta phбәЈi lГ m thГҙng qua cГЎc phЖ°ЖЎng phГЎp TrГӯ thГҙng minh NhГўn tбәЎo thб»ӯ nghiб»Үm, nhЖ°ng cЕ©ng thГҙng qua cГЎc phЖ°ЖЎng phГЎp khГҙng liГӘn quan Д‘бәҝn sб»ұ chuyГӘn sГўu vб»Ғ chuyГӘn gia cГҙng nghб»Ү trong lД©nh vб»ұc TrГӯ tuб»Ү NhГўn tбәЎo.

VГ¬ vбәӯy, nhб»Ҝng ngЖ°б»қi Д‘ang lГ m viб»Үc vб»Ғ an toГ n TrГӯ tuб»Ү NhГўn tбәЎo hiб»Үn nay, Д‘Гі lГ cГҙng viб»Үc Д‘ГЎng khen, nhЖ°ng nhiб»Ғu cГҙng viб»Үc của hб»Қ rбәҘt hбәЎn hбә№p vГ chГ¬m Д‘бәҜm vГ o thuбәӯt toГЎn hiб»Үn tбәЎi. Thuбәӯt toГЎn Д‘Гі sau 3 nДғm cГі thб»ғ trб»ҹ nГӘn khГҙng quan trб»Қng. Vбәӯy nбәҝu chГәng ta khГҙng nghД© vб»Ғ Д‘б»ҷng lб»ұc xГЈ hб»ҷi lб»ӣn hЖЎn hoбә·c бәЈnh hЖ°б»ҹng của quбәЈn lГҪ, hoбә·c xГўy dб»ұng LiГӘn Hiб»Үp Quб»‘c mб»ӣi thб»ұc sб»ұ hiб»ғu vб»Ғ cГҙng nghб»Ү, thГ¬ chГәng ta sбәҪ lГ m gГ¬?

Nhб»Ҝng ngЖ°б»қi Д‘ang lГ m viб»Үc vб»Ғ an toГ n TrГӯ tuб»Ү NhГўn tбәЎo hiб»Үn nay, Д‘Гі lГ cГҙng viб»Үc Д‘ГЎng khen, nhЖ°ng nhiб»Ғu cГҙng viб»Үc của hб»Қ rбәҘt thiб»ғn cбәӯn vГ Д‘i sГўu vГ o thuбәӯt toГЎn hiб»Үn tбәЎi. Thuбәӯt toГЎn Д‘Гі sau 3 nДғm cГі thб»ғ trб»ҹ nГӘn khГҙng quan trб»Қng. Vбәӯy nбәҝu chГәng ta khГҙng nghД© vб»Ғ Д‘б»ҷng lб»ұc xГЈ hб»ҷi lб»ӣn hЖЎn hoбә·c бәЈnh hЖ°б»ҹng của quбәЈn lГҪ, hoбә·c xГўy dб»ұng LiГӘn Hiб»Үp Quб»‘c mб»ӣi thб»ұc sб»ұ hiб»ғu vб»Ғ cГҙng nghб»Ү, thГ¬ chГәng ta sбәҪ lГ m gГ¬?

Vбәӯy nГӘn, chГәng ta phбәЈi thб»ұc hiб»Үn tбәҘt cбәЈ nhб»Ҝng Д‘iб»Ғu trГӘn.

Adel Nehme: TГҙi hoГ n toГ n Д‘б»“ng ГҪ vГ anh Д‘ГЈ Д‘б»Ғ cбәӯp Д‘бәҝn mб»ҷt Д‘iб»Ғu б»ҹ Д‘Гўy, Д‘Гі lГ nhб»Ҝng бәЈnh hЖ°б»ҹng xГЈ hб»ҷi vГ Д‘iб»Ғu mГ tГҙi cбәЈm thбәҘy rбәҘt cuб»‘n hГәt, Д‘бә·c biб»Үt lГ trong thбәӯp kб»· tб»ӣi vб»ӣi sб»ұ gia tДғng của cГЎc hб»Ү thб»‘ng TrГӯ thГҙng minh NhГўn tбәЎo mбәЎnh mбәҪ hЖЎn.В

Mб»ҷt Д‘iб»Ғu mГ tГҙi thЖ°б»қng xuyГӘn nghД© Д‘бәҝn lГ бәЈnh hЖ°б»ҹng tiб»Ғm бә©n của TrГӯ tuб»Ү NhГўn tбәЎo Д‘б»‘i vб»ӣi thб»Ӣ trЖ°б»қng lao Д‘б»ҷng vГ¬ nбәҝu chГәng ta cГі sб»ұ biбәҝn Д‘б»ҷng tiб»Ғm бә©n trong thб»Ӣ trЖ°б»қng lao Д‘б»ҷng, Д‘iб»Ғu Д‘Гі cГі thб»ғ dбә«n Д‘бәҝn nhiб»Ғu бәЈnh hЖ°б»ҹng tiГӘu cб»ұc nhЖ°: Sб»ұ xuбәҘt hiб»Үn của cГЎc nhГ lГЈnh Д‘бәЎo Д‘б»ҷc tГ i, khбәЈ nДғng suy thoГЎi kinh tбәҝ cГі thб»ғ dбә«n Д‘бәҝn nhiб»Ғu sб»ұ cбәЎm bбә«y giб»Ҝa cГЎc quб»‘c gia vГ Д‘iб»Ғu nГ y gia tДғng thГӘm cДғng thбәіng Д‘б»Ӣa chГӯnh trб»Ӣ.

Vбәӯy cГі nhiб»Ғu mб»‘i quan hб»Ү khГЎc nhau Д‘ang diб»…n ra б»ҹ Д‘Гўy theo gГіc Д‘б»ҷ rủi ro lan truyб»Ғn. VГ¬ vбәӯy, cГі thб»ғ anh nГіi rГө hЖЎn vб»Ғ cГЎch anh Д‘ГЎnh giГЎ бәЈnh hЖ°б»ҹng của TrГӯ tuб»Ү NhГўn tбәЎo Д‘б»‘i vб»ӣi nДғng suбәҘt, lao Д‘б»ҷng, thб»Ӣ trЖ°б»қng lao Д‘б»ҷng vГ nhб»Ҝng бәЈnh hЖ°б»ҹng tiГӘu cб»ұc hoбә·c tГӯch cб»ұc tiб»Ғm бә©n trong nhб»Ҝng nДғm sбәҜp tб»ӣi?

Trond Arne Undheim: ДҗГәng vбәӯy, tГҙi nghД© kiб»ғu Д‘бә·c Д‘iб»ғm phб»• biбәҝn trЖ°б»ӣc cЖЎn sб»‘t TrГӯ tuб»Ү NhГўn tбәЎo mб»ӣi nhбәҘt nГ y lГ nГіi hoбә·c lГ robot vГ cГҙng nghб»Ү sбәҪ thay thбәҝ tбәҘt cбәЈ cГЎc cГҙng viб»Үc. VГ Д‘Гәng nhЖ° vбәӯy, nhЖ°ng sau Д‘Гі lбәӯp luбәӯn Д‘Гі phбә§n lб»ӣn Д‘ГЈ bб»Ӣ bГЎc bб»Ҹ. NГі khГҙng trГҙng nhЖ° vбәӯy. ДҗГі lГ mб»ҷt nghiГӘn cб»©u lб»ӣn của MIT chб»ү nГіi rбәұng, tбәҘt cбәЈ robot б»ҹ Д‘Гўu, phбәЈi khГҙng?

NГі kГ©o dГ i hЖЎn thб»қi gian dб»ұ kiбәҝn. VГ robot hiб»Үn tбәЎi khГҙng thб»ғ thay thбәҝ tбәҘt cбәЈ cГЎc cГҙng viб»Үc, vГ cГі lбәҪ con ngЖ°б»қi khГҙng quan tГўm Д‘бәҝn viб»Үc robot tЖ°ЖЎng lai thay thбәҝ mб»ҷt sб»‘ cГҙng viб»Үc Д‘Гі, cГҙng viб»Үc của hб»Қ phб»©c tбәЎp hЖЎn so vб»ӣi vбә» bб»Ғ ngoГ i. BГўy giб»қ, mГҙ hГ¬nh ngГҙn ngб»Ҝ lб»ӣn lбәЎi xuбәҘt hiб»Үn.

NГі mбәҘt nhiб»Ғu thб»қi gian hЖЎn. VГ cГі lбәҪ robot hiб»Үn Д‘бәЎi khГҙng thб»ғ thay thбәҝ tбәҘt cбәЈ cГЎc cГҙng viб»Үc, cГі thб»ғ con ngЖ°б»қi thбәӯm chГӯ khГҙng quan tГўm Д‘бәҝn viб»Үc trong tЖ°ЖЎng lai, robot sбәҪ thay thбәҝ mб»ҷt sб»‘ cГҙng viб»Үc Д‘Гі, vГ cГҙng viб»Үc của hб»Қ phб»©c tбәЎp hЖЎn so vб»ӣi cГЎi vбә» bб»Ғ ngoГ i. BГўy giб»қ, mГҙ hГ¬nh ngГҙn ngб»Ҝ lб»ӣn cГі lбәҪ Д‘ГЈ thay Д‘б»•i mб»ҷt chГәt cбәЈm nhбәӯn Д‘Гі.В

VГ tГҙi nghД© cГі nhiб»Ғu cГҙng viб»Үc hЖЎn mГ cГҙng nghб»Ү cГі thб»ғ Д‘бәЈm nhбәӯn, nhЖ°ng chủ yбәҝu, Д‘iб»Ғu nГ y Д‘б»“ng thuбәӯn vб»ӣi lбәӯp luбәӯn trong cuб»‘n sГЎch của chГәng tГҙi, “Augmented Lean,” nЖЎi chГәng tГҙi nghiГӘn cб»©u vб»Ғ cГҙng nghб»Ү sбәЈn xuбәҘt chГӯnh nГі vГ o nДғm ngoГЎi. ДҗГі lГ sб»ұ kбәҝt hб»Јp giб»Ҝa con ngЖ°б»қi vГ cГҙng nghб»Ү luГҙn chiбәҝn thбәҜng.

NГі rбәҘt rГө rГ ng trong lД©nh vб»ұc sбәЈn xuбәҘt thб»ұc tбәҝ vГ¬ mб»Қi cГҙng nghб»Ү nГ o mГ rЖЎi vГ o lД©nh vб»ұc Д‘Гі ban Д‘бә§u Д‘б»Ғu tб»ұ Д‘б»ҷng hГіa nhiб»Ғu vГ sau khi nГі tГӯch hб»Јp vГ o hб»Ү thб»‘ng, con ngЖ°б»қi tiбәҝp quбәЈn cГЎc chб»©c nДғng cГі giГЎ trб»Ӣ cao hЖЎn vГ chб»ү lГ m thay Д‘б»•i cГЎch hб»Қ sб»ӯ dб»Ҙng cГҙng nghб»Ү, sau Д‘Гі mб»ҷt sб»‘ cГҙng nghб»Ү bб»Ӣ Д‘бә·t б»ҹ kб»Ү hoбә·c nбәұm б»ҹ phГӯa sau vГ nГі rбәҘt Д‘бәҜt Д‘б»Ҹ.

VГ Д‘Гі lГ mб»ҷt thГЎch thб»©c lб»ӣn vб»Ғ thб»қi gian vГ nДғng lЖ°б»Јng. VГ nГі khГі Д‘Г o tбәЎo cho ngЖ°б»қi lao Д‘б»ҷng vГ thбәҘt bбәЎi mбә·c dГ№ nГі rбәҘt tiГӘn tiбәҝn. VГ¬ vбәӯy, tГҙi nghД© sб»ұ ГЎm бәЈnh nГ y xung quanh cГҙng nghб»Ү tiГӘn tiбәҝn, Д‘бәҜt Д‘б»Ҹ nhбәҘt cГі thб»ғ. NГі chб»ү dбә«n Д‘бәҝn sб»ұ phб»©c tбәЎp khГҙng cбә§n thiбәҝt. VГ¬ vбәӯy, tГҙi nghД© cЖЎ bбәЈn lГ thб»Ӣ trЖ°б»қng lao Д‘б»ҷng sбәҪ phбәЈi Д‘iб»Ғu chб»үnh.

VГ chГәng ta cГі thб»ғ chб»ү thбәҘy mб»ҷt sб»‘ khбәЈ nДғng hiб»Үn tбәЎi mГ бәЈnh hЖ°б»ҹng của AR cГі thб»ғ lГ m rб»ҷng hЖЎn, cГі thб»ғ lГ m tб»“i tб»Ү hЖЎn Д‘б»‘i vб»ӣi mб»ҷt sб»‘ nhГіm cГҙng nhГўn khГҙng thГӯch б»©ng, khГҙng hб»Қc kб»№ nДғng mб»ӣi. CГі lбәҪ nГі sбәҪ tб»“i tб»Ү hЖЎn nhiб»Ғu so vб»ӣi chГәng ta nghД©. NhЖ°ng ngЖ°б»Јc lбәЎi, cГі nhб»Ҝng hiб»Үu б»©ng kГ©o dГ i mГ con ngЖ°б»қi cГі khi chГәng ta thб»ұc sб»ұ tiбәҝp quбәЈn vГ quбәЈn lГҪ, vГ trong lД©nh vб»ұc của tГҙi, chГәng ta gб»Қi Д‘Гі lГ thuбә§n hГіa cГҙng nghб»Ү.

ChГәng tГҙi biбәҝn nГі thГ nh của riГӘng mГ¬nh, cГі nghД©a lГ chГәng tГҙi thб»ұc sб»ұ chб»Ӣu trГЎch nhiб»Үm vб»Ғ nГі. Sau Д‘Гі, chГәng ta tбәӯn dб»Ҙng nГі vГ trб»ҹ nГӘn linh hoбәЎt hЖЎn. Tuy nhiГӘn, Д‘Гўy lГ mб»ҷt hГ¬nh бәЈnh rбәҘt lбәЎc quan nбәҝu bбәЎn khГҙng cГі hб»Қc vбәҘn, khГҙng cГі tГ i nguyГӘn, khГҙng thб»ғ Д‘бәҝn trЖ°б»қng, vГ nбәҝu bбәЎn chб»ү lГ ngЖ°б»қi nhбәӯn tбәҘt cбәЈ nhб»Ҝng thay Д‘б»•i nГ y. Nбәҝu bбәЎn Д‘ang б»ҹ cuб»‘i quang phб»• Д‘Гі.

ДҗГі lГ mб»ҷt thбәҝ giб»ӣi rбәҘt thГЎch thб»©c mГ chГәng ta Д‘ang bЖ°б»ӣc vГ o.

Adel Nehme: ДҗГәng vбәӯy, vГ sбәҪ cбә§n cГі mб»ҷt hГ¬nh thб»©c phбәЈn б»©ng nГ o Д‘Гі. Дҗб»ғ giбәЈm thiб»ғu rủi ro Д‘Гі, Д‘Гәng khГҙng, vГ tб»‘i Ж°u hГіa kбәҝt quбәЈ tб»‘t hЖЎn. Trong ngб»Ҝ cбәЈnh bбәЎn Д‘ang mГҙ tбәЈ, bбәЎn nghД© rбәұng phбәЈn б»©ng nГ o tб»« cГЎc tб»• chб»©c chГӯnh phủ, vГӯ dб»Ҙ nhЖ° khuyбәҝn khГӯch viб»Үc Д‘Г o tбәЎo lбәЎi kб»№ nДғng vГ giГәp mб»Қi ngЖ°б»қi tГ¬m Д‘Ж°б»қng trong thбәҝ giб»ӣi mб»ӣi nГ y, sбәҪ lГ mб»ҷt phбәЈn б»©ng tб»‘t?

Trond Arne Undheim: TГҙi nghД© vai trГІ của chГӯnh phủ trong viб»Үc nГўng cao kб»№ nДғng vГ Д‘Г o tбәЎo lбәЎi cГҙng nhГўn vГ thбәӯm chГӯ lГ thay Д‘б»•i hб»Ү thб»‘ng giГЎo dб»Ҙc vбә«n cГІn. TГҙi nghД© cГЎc cГҙng nghб»Ү nhЖ° AI sбәҪ cГі nhб»Ҝng бәЈnh hЖ°б»ҹng vб»Ғ nДғng suбәҘt rбәҘt lб»ӣn, nhЖ°ng chГәng khГҙng Д‘б»“ng nghД©a vб»ӣi viб»Үc loбәЎi bб»Ҹ mб»ҷt toГ n bб»ҷ tбә§ng lб»ӣp cГҙng dГўn vГ cГҙng nhГўn chб»ү vГ¬ hб»Қ trб»ҹ nГӘn phб»©c tбәЎp hЖЎn.

VГ tГҙi cЕ©ng nghД© rбәұng, trГЎch nhiб»Үm của chГӯnh phủ lГ Д‘бәЈm bбәЈo rбәұng ngay cбәЈ khi cГЎc cГҙng nghб»Ү mang lбәЎi nhб»Ҝng kбәҝt quбәЈ phб»©c tбәЎp vГ hб»©ng thГә, giao diб»Үn của chГәng lГ dб»… sб»ӯ dб»Ҙng. VГ tГҙi nghД© rбәұng Д‘iб»Ғu nГ y cГі thб»ғ Д‘Ж°б»Јc yГӘu cбә§u. ChГәng tГҙi Д‘ГЈ viбәҝt vб»Ғ Д‘iб»Ғu Д‘Гі trong “Augmented Lean,” cuб»‘n sГЎch của chГәng tГҙi vб»Ғ tЖ°ЖЎng lai của sбәЈn xuбәҘt kб»№ thuбәӯt sб»‘. ДҗГўy lГ mб»ҷt cЖЎ hб»ҷi mГ chГӯnh phủ khГҙng nГӘn tб»« bб»Ҹ, cЖЎ hб»ҷi Д‘б»ғ Д‘Ж°a ra yГӘu cбә§u vб»Ғ cГЎc cГҙng nghб»Ү Д‘ЖЎn giбәЈn vб»ӣi giao diб»Үn mГ cбәЈ ngЖ°б»қi sб»ӯ dб»Ҙng vГ quбәЈn lГҪ cГҙng nghб»Ү cГі thб»ғ thГӯch б»©ng gбә§n nhЖ° ngay lбәӯp tб»©c mГ khГҙng cбә§n Д‘Г o tбәЎo, khГҙng cбә§n mГЈ.

Дҗiб»Ғu nГ y thб»ұc sб»ұ quan trб»Қng. Nбәҝu chГәng ta coi Д‘Гі lГ mб»ҷt nguyГӘn tбәҜc, thГ¬ dГ№ cГҙng nghб»Ү cЖЎ bбәЈn cГі phб»©c tбәЎp Д‘бәҝn Д‘Гўu, viб»Үc sб»ӯ dб»Ҙng sбәҪ rбәҘt Д‘ЖЎn giбәЈn, khГҙng cГі lГҪ do gГ¬ cГі thб»ғ bГ o chб»Ҝa. Nбәҝu bбәЎn khГҙng tб»ұ giГЎo dб»Ҙc mГ¬nh, nбәҝu bбәЎn khГҙng cГі tinh thбә§n tГӯch cб»ұc, nбәҝu bбәЎn khГҙng muб»‘n thay Д‘б»•i, thГ¬ bбәЎn sбәҪ trб»ҹ thГ nh ngЖ°б»қi lao Д‘б»ҷng trб»ҹ nГӘn dЖ° thб»«a. TГҙi nghД© rбәұng chГәng ta tбәҘt cбәЈ nГӘn cГі khбәЈ nДғng tб»ұ Д‘бә·t lбәЎi mГ¬nh vГ o thб»Ӣ trЖ°б»қng lao Д‘б»ҷng. VГ tГҙi khГҙng thбәҘy cГі lГҪ do gГ¬ chГӯnh phủ khГҙng thб»ғ Д‘бәЈm bбәЈo Д‘iб»Ғu Д‘Гі xбәЈy ra, dГ№ lГ vб»ӣi trГӯ tuб»Ү nhГўn tбәЎo tiГӘn tiбәҝn hay bбәҘt kб»і cГҙng nghб»Ү nГ o khГЎc cГі tГЎc Д‘б»ҷng liГӘn quan.

Adel Nehme: VГ khi chГәng ta kбәҝt thГәc vб»ӣi thГҙng Д‘iб»Үp lбәЎc quan nГ y, Д‘iб»Ғu bбәЎn hi vб»Қng cho trГӯ tuб»Ү nhГўn tбәЎo trong tЖ°ЖЎng lai ngбәҜn hбәЎn lГ gГ¬? BбәЎn nghД© cГі nhб»Ҝng quy Д‘б»Ӣnh mбәЎnh mбәҪ nГ o chГәng ta cбә§n thб»ұc hiб»Үn Д‘б»ғ kiб»Ғm chбәҝ mб»ҷt sб»‘ rủi ro mГ chГәng ta Д‘ГЈ thбәЈo luбәӯn hГҙm nay khГҙng?

Trond Arne Undheim: TГҙi vбә«n hy vб»Қng cГі mб»ҷt khuГҙn khб»• phГЎp lГҪ toГ n cбә§u cho AI. TГҙi hy vб»Қng vб»Ғ Д‘iб»Ғu Д‘Гі. TГҙi khГҙng nghД© rбәұng Д‘iб»Ғu Д‘Гі lГ khГі khДғn vГ tГҙi nghД© chГәng ta cГі thб»ғ giбәЈi quyбәҝt vб»ӣi nГі, ngay cбәЈ nбәҝu chГәng ta cГі cГЎc hб»Ү thб»‘ng khu vб»ұc. TГҙi hy vб»Қng vГ tГҙi Д‘ang thб»ұc hiб»Үn mб»ҷt sб»‘ chЖ°ЖЎng trГ¬nh Д‘Г o tбәЎo lбәЎi cho cГЎc quyбәҝt Д‘б»Ӣnh gia chГӯnh phủ. TГҙi nghД© vб»ӣi tЖ° cГЎch lГ mб»ҷt ngЖ°б»қi tб»«ng lГ m ngЖ°б»қi quy Д‘б»Ӣnh, tГҙi biбәҝt giГЎ trб»Ӣ của viб»Үc cб»‘ gбәҜng cбәӯp nhбәӯt, cб»‘ gбәҜng rбәҘt nhiб»Ғu Д‘б»ғ hiб»ғu rГө cГЎc cГҙng nghб»Ү khi chГәng mб»ӣi xuбәҘt hiб»Үn.

VГ tГҙi nghД© rбәұng hб»Ү thб»‘ng chГӯnh phủ của chГәng ta khГҙng cГі chiбәҝn lЖ°б»Јc tб»‘t Д‘б»ғ thб»ұc hiб»Үn giГЎo dб»Ҙc ngay trong cГҙng viб»Үc nhЖ° vбәӯy. NhЖ°ng cГі cГЎc hб»ҷi Д‘б»“ng cГҙng nghб»Ү vГ cГЎc hб»ҷi Д‘б»“ng tЖ° vбәҘn cГ№ng cГЎc trЖ°б»қng Д‘бәЎi hб»Қc. ChГәng tГҙi vб»«a cГі cГЎc cГЎn bб»ҷ lбәӯp phГЎp của Quб»‘c hб»ҷi Д‘бәҝn Stanford. ChГәng tГҙi Д‘ГЈ cГі ba ngГ y tuyб»Үt vб»қi vб»ӣi hб»Қ vГ chГәng tГҙi Д‘ГЈ hб»Қc hб»Ҹi lбә«n nhau.

Nhб»Ҝng Д‘iб»Ғu nГ y cбә§n trб»ҹ thГ nh mб»ҷt phбә§n của hб»Ү thб»‘ng chГӯnh trб»Ӣ. Trong trЖ°б»қng hб»Јp của chГәng tГҙi, chủ yбәҝu lГ nhб»Ҝng cГЎn bб»ҷ nhб»Ҹ tuб»•i hЖЎn. TГҙi nghД©, vб»ӣi viб»Үc cГі nhб»Ҝng ngЖ°б»қi quyбәҝt Д‘б»Ӣnh cГі kinh nghiб»Үm rбәҘt lб»ӣn б»ҹ cГЎc cЖЎ quan quy Д‘б»Ӣnh trГӘn khбәҜp thбәҝ giб»ӣi mГ cГі thб»ғ thuб»ҷc Д‘б»ҷ tuб»•i khГЎc nhau, nhб»Ҝng ngЖ°б»қi Д‘Гі cЕ©ng sбәҪ cбә§n mб»ҷt cГЎch tiбәҝp cбәӯn Д‘Ж°б»Јc Д‘бә·t ra khГЎc biб»Үt Д‘б»ғ hiб»ғu cГЎch cГҙng nghб»Ү phГЎt triб»ғn.

Дҗiб»Ғu nГ y khГҙng phбәЈi lГ mб»ҷt viб»Үc dб»… dГ ng vГ khГҙng phбәЈi lб»—i của hб»Қ khi hб»Қ Д‘Ж°б»Јc giГЎo dб»Ҙc trong mб»ҷt thб»қi Д‘бәЎi khi cГҙng nghб»Ү kГ©o dГ i 30 nДғm hoбә·c hЖЎn. Trong mб»ҷt thб»қi kб»і mГ cГҙng nghб»Ү cГі thб»ғ chб»ү tб»“n tбәЎi trong ba thГЎng, bбәЎn cбә§n phбәЈi Д‘iб»Ғu chб»үnh hб»Ү thб»‘ng giГЎo dб»Ҙc của mГ¬nh cho phГ№ hб»Јp. BбәЎn khГҙng thб»ғ chб»ү quan tГўm Д‘бәҝn mб»ҷt cГҙng nghб»Ү. BбәЎn phбәЈi hiб»ғu tбәЎi sao nГі Д‘Ж°б»Јc tбәЎo ra vГ nhбәӯn ra rбәұng nбәҝu bбәЎn Д‘бә§u tЖ° mб»ҷt nДғm Д‘б»ғ hiб»ғu vб»Ғ mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі, nГі cГі thб»ғ biбәҝn mбәҘt vГ trб»ҹ nГӘn khГҙng ГҪ nghД©a gГ¬ vГ o thГЎng tiбәҝp theo.

VГ¬ vбәӯy, bбәЎn cбә§n phбәЈi cГі mб»ҷt cГЎch tiбәҝp cбәӯn khГЎc vГ cГЎc cЖЎ quan quбәЈn lГҪ cбә§n phбәЈi lГ m Д‘iб»Ғu nГ y. NhЖ°ng tГҙi nghД© rбәұng cГЎc quбәЈn lГҪ б»ҹ mб»Қi cбәҘp Д‘б»ҷ trong xГЈ hб»ҷi cЕ©ng cбә§n phбәЈi cГі nhбәӯn thб»©c Д‘Гі. Hб»Қc cГЎch hб»Қc, khГҙng phбәЈi chб»ү hб»Қc mб»ҷt Д‘iб»Ғu gГ¬ Д‘Гі.

Adel Nehme: VГ tГҙi hoГ n toГ n Д‘б»“ng ГҪ. VГ khi chГәng ta kбәҝt thГәc tбәӯp phim hГҙm nay, Trond, bбәЎn cГі thГҙng Д‘iб»Үp cuб»‘i cГ№ng nГ o cho ngЖ°б»қi nghe trЖ°б»ӣc khi kбәҝt thГәc tбәӯp phim hГҙm nay khГҙng?

Trond Arne Undheim: TГҙi Ж°б»ӣc tбәҘt cбәЈ chГәng ta cГі thб»ғ hГӯt mб»ҷt hЖЎi thбәӯt sГўu vГ nhбәӯn ra rбәұng nhб»Ҝng gГ¬ AI sбәҪ lГ m phбә§n lб»ӣn lГ nhб»Ҝng gГ¬ chГәng ta sбәҪ cho phГ©p nГі lГ m, chб»© khГҙng phбәЈi lГ nhб»Ҝng gГ¬ trГӯ tuб»Ү nhГўn tбәЎo sбәҪ lГ m gГ¬ vб»ӣi chГәng ta. VГ Д‘iб»Ғu nГ y phГ№ hб»Јp vб»ӣi bбәҘt kб»і cГҙng nghб»Ү mб»ӣi nб»•i nГ o.В б»һ Д‘Гі, khГҙng cГі lб»ұc lЖ°б»Јng nГ o Д‘Ж°б»Јc gб»Қi lГ cГҙng nghб»Ү mб»ӣi nб»•i Д‘бәҝn vб»ӣi chГәng ta nhЖ° thб»ғ nГі Д‘бәҝn tб»« sao Hб»Ҹa.

NГі Д‘бәҝn tб»« con ngЖ°б»қi. Con ngЖ°б»қi tбәЎo ra nГі. ChГәng ta chб»Ӣu trГЎch nhiб»Үm vб»Ғ nГі. ChГәng ta cбә§n phбәЈi giбәЈi quyбәҝt nГі. VГ Д‘Гі lГ mб»ҷt dб»ұ ГЎn liГӘn tб»Ҙc, nГӘn khГҙng cГі gГ¬ phбәЈi sб»Ј, nhЖ°ng viб»Үc khГҙng hГ nh Д‘б»ҷng lГ Д‘iб»Ғu tГҙi sб»Ј nhбәҘt.

Adel Nehme: Дҗiб»Ғu Д‘Гі thб»ұc sб»ұ tuyб»Үt vб»қi. VГ Д‘iб»Ғu nГ y chбәҜc chбәҜn Д‘б»Ғu nбәұm trong tay chГәng ta. CбәЈm ЖЎn Trond rбәҘt nhiб»Ғu vГ¬ Д‘ГЈ tham gia chЖ°ЖЎng trГ¬nh DataFramed.

Trond Arne Undheim: ДҗГі lГ niб»Ғm vinh hбәЎnh của tГҙi.

AI Д‘ГЈ vГ Д‘ang gГіp phбә§n quan trб»Қng vГ o cuб»ҷc sб»‘ng hГ ng ngГ y của chГәng ta.

TrГӯ thГҙng minh nhГўn tбәЎo (AI) lГ mб»ҷt thГЎch thб»©c vГ cЖЎ hб»ҷi Д‘б»“ng thб»қi. Дҗб»‘i vб»ӣi mб»ҷt tЖ°ЖЎng lai tГӯch cб»ұc, chГәng ta cбә§n Д‘бәЈm bбәЈo sб»ұ kiб»ғm soГЎt vГ quбәЈn lГҪ chбә·t chбәҪ vб»Ғ cГҙng nghб»Ү nГ y. NativeX Д‘ГЈ Д‘б»Ғ cбәӯp Д‘бәҝn nhб»Ҝng khГӯa cбәЎnh quan trб»Қng của AI vГ nhбәҘn mбәЎnh tбә§m quan trб»Қng của quбәЈn lГҪ vГ giГЎo dб»Ҙc Д‘б»ғ Д‘б»‘i mбә·t vб»ӣi nhб»Ҝng thГЎch thб»©c trong bГ i viбәҝt nГ y. HГЈy chia sбә» ГҪ kiбәҝn của bбәЎn vГ thбәЈo luбәӯn thГӘm vб»Ғ chủ Д‘б»Ғ nГ y. BбәЎn cГі thб»ғ Д‘б»ғ lбәЎi ГҪ kiбәҝn của mГ¬nh dЖ°б»ӣi Д‘Гўy vГ chia sбә» bГ i viбәҝt Д‘б»ғ lan tб»Ҹa nhбәӯn thб»©c vб»Ғ trГӯ thГҙng minh nhГўn tбәЎo.

NativeX – Hб»Қc tiбәҝng Anh online toГ n diб»Үn “4 kб»№ nДғng ngГҙn ngб»Ҝ” cho ngЖ°б»қi Д‘i lГ m.

Vб»ӣi mГҙ hГ¬nh “Lб»ӣp Hб»Қc NГ©n” Д‘б»ҷc quyб»Ғn:

- TДғng hЖЎn 20 lбә§n chбәЎm “Д‘iб»ғm kiбәҝn thб»©c”, giГәp hiб»ғu sГўu vГ nhб»ӣ lГўu hЖЎn gбәҘp 5 lбә§n.

- TДғng khбәЈ nДғng tiбәҝp thu vГ tбәӯp trung qua cГЎc bГ i hб»Қc cГҙ Д‘б»Қng 3 – 5 phГәt.

- RГәt ngбәҜn gбә§n 400 giб»қ hб»Қc lГҪ thuyбәҝt, tДғng hЖЎn 200 giб»қ thб»ұc hГ nh.

- HЖЎn 10.000 hoбәЎt Д‘б»ҷng cбәЈi thiб»Үn 4 kб»№ nДғng ngoбәЎi ngб»Ҝ theo giГЎo trГ¬nh chuбә©n Quб»‘c tбәҝ tб»« National Geographic Learning vГ Macmillan Education.

TГЎc giбәЈ: NativeX